Made by Dirty Pomelo. Think that.(Talk about gender&society)

chatGPT,可以是一個女性主義的AI麼? ——AI人工智慧算法倫理的社會脈絡【臟柚子·社會觀察-1】

3月8日國際女性日一直主要是共產主義節日,直到大約1967 年它被第二波女權主義者重新詮釋。這一天重新成為激進女性主義的一天,有時在歐洲被稱為“婦女國際鬥爭日”。在1970 年代和80 年代,婦女團體與左翼分子和勞工組織一起呼籲同工同酬、平等經濟機會、平等法律權利、生殖權利、補貼兒童保育和防止對婦女的暴力行為。

Dirty Pomelo的性別與社會(生物和科學角度的Gender)連載已經開始了接近一個月,感謝平台和讀者的支持。三月八日是值得一起發聲的日子,今天作為連載途中女性節日的特別篇,想大家一起來聊女性和AI技術。

如果大家喜歡,這個系列可能也會繼續進行。

現在暫時稱為【臟柚子社會觀察DPWW: Dirty Pomelo Wide Watch】

1 科技的社會土壤

chatGPT,它是可能是今年開年最具有關注點的科技事件。 ChatGPT 感覺不一樣。更聰明。更靈活。被專家譽為AI 進化的引爆點,並以比Instagram 和TikTok更快的速度獲得用戶,chatGPT迫使我們重新評估我們的學習、工作和思考方式,質疑是什麼讓我們與眾不同。

嚴格來說,支持ChatGPT 的技術並不新鮮。它基於公司所謂的“GPT-3.5”,這是GPT-3 的升級版本,GPT-3 是AI 文本生成器,在2020 年問世時引發了一陣興奮。但是,雖然強大的語言超級大腦的存在可能對於AI 研究人員來說是個老新聞了,但這是第一次通過免費、易於使用的Web 界面向公眾提供如此強大的工具。

然而,毫無疑問,這種大型語言模型(LLM) 與任何AI 一樣,都受到它所攝取信息的質量和準確性的限制。事實上,與人類不同,算法沒有脆弱的自尊,它們也不會有意識或無意識的偏見,更不用說道德判斷了。人工智慧和它的訓練師關係似乎和訓犬師和受訓的狗狗一樣。

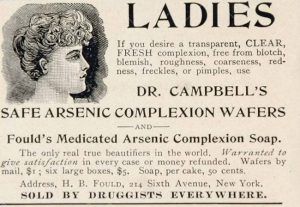

但事實上, 我們之前四期的連載試圖說明的是,科學研究的傾向,範式,是受到社會環境影響的。瘋狂的科學家存在的時代和我們沒有同樣的審美和道德。所以他們的行為似乎讓現代人難以共情。那現在的我們呢?我們嘲笑古代人離奇的風俗,驚訝於吞食砒霜的怪異行為。我們的時代又是怎麼樣的?

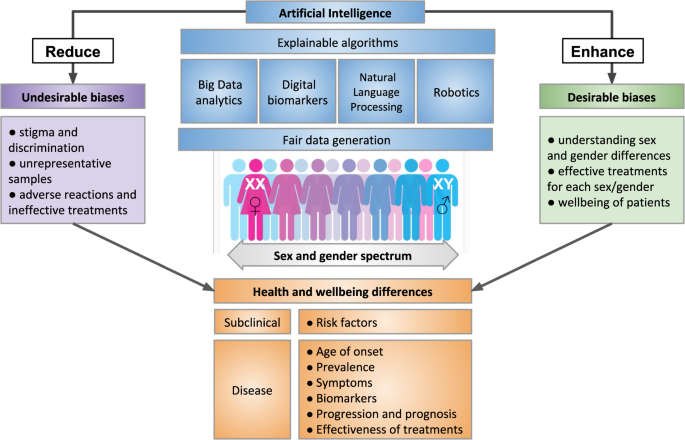

AI人工智慧

人工智慧AI的主要功能是利用更廣泛的數據,利用代替人類做出更理性的判斷。輔助人類完成日常行為。所以人工智能技術的主要組成是

- 來自機器硬件水平的算力,

- 來自人工設計的算法。

- 來自廣泛收集的數據。

(可能不夠嚴謹,歡迎評論我~)

機器通過對於數據的學習形成人工智能。可以看出,人工智慧極度依賴數據和算法形成所謂的“智慧”。而算法中對於數據優先級和權重的分配來自人的判斷。而數據也是由人產生。即使發展出深度學習和神經網絡等更加複雜的信息處理和優化形式。但仍然很難逃離人的意識形態影響和控制。數據對於人工智能的發展有可能也在促進數據和科技的新形勢下的隱性歧視。

亞馬遜的AI系統的例子。女性相關詞彙的簡歷會被AI系統降級。

為了優化人力資源,亞馬遜創建了一種算法,該算法源自10 年來提交給亞馬遜的簡歷。它使用的數據以亞馬遜以男性為主的高績效工程部門為基準。算法被教導識別單詞模式,而不是簡歷中的相關技能集,並且看到歷史上男性被雇用和晉升,算法自學了降級任何包含“女性”一詞的簡歷,例如“女子國際象棋” 俱樂部隊長”,並降低了參加過兩所“女子大學”的女性的簡歷。 這是因為包含人類偏見或歷史歧視的訓練數據,創造了一個自我實現的預言循環,機器學習吸收人類偏見並複制它,將其納入未來決策,並使隱性偏見成為明確的現實。

儘管多次嘗試糾正算法並消除被認為是簡單的技術修復的偏見,但都沒有成功,亞馬遜最終還是放棄了算法招聘工具,因為這種偏見在亞馬遜過去的招聘實踐中根深蒂固。偏差深深地隱含在訓練算法的數據中,機器學習ADM 系統無法“消除”偏差。 2017 年,亞馬遜放棄了該項目,並通過路透社與公眾分享了他們的經驗。

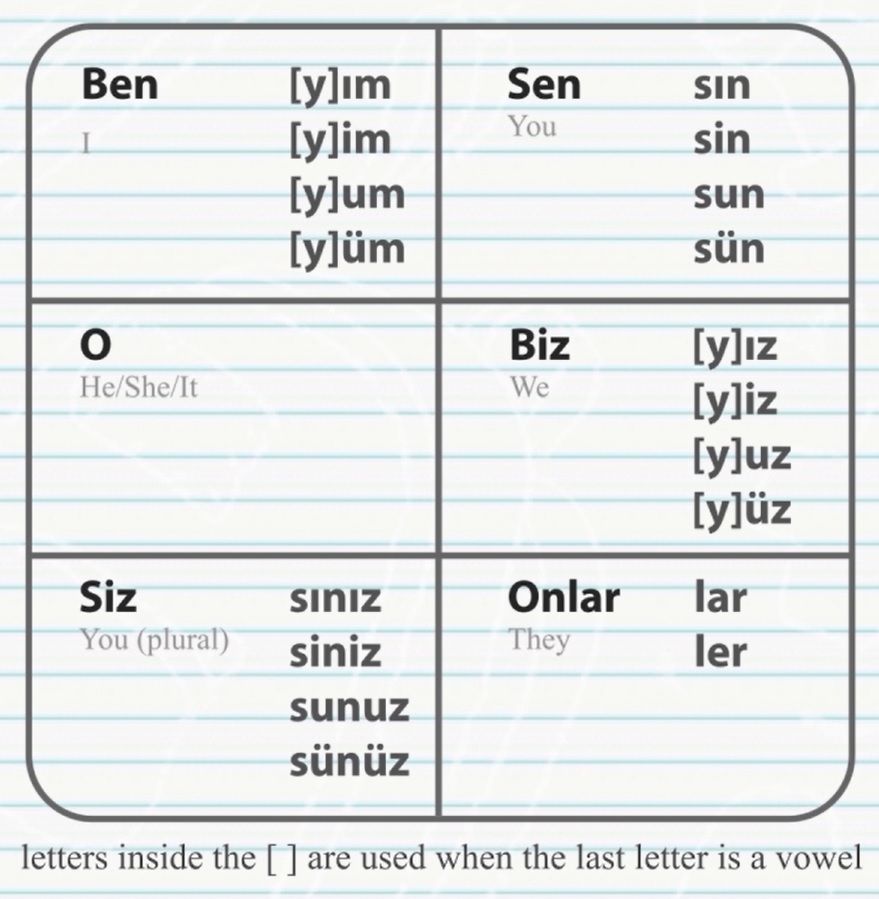

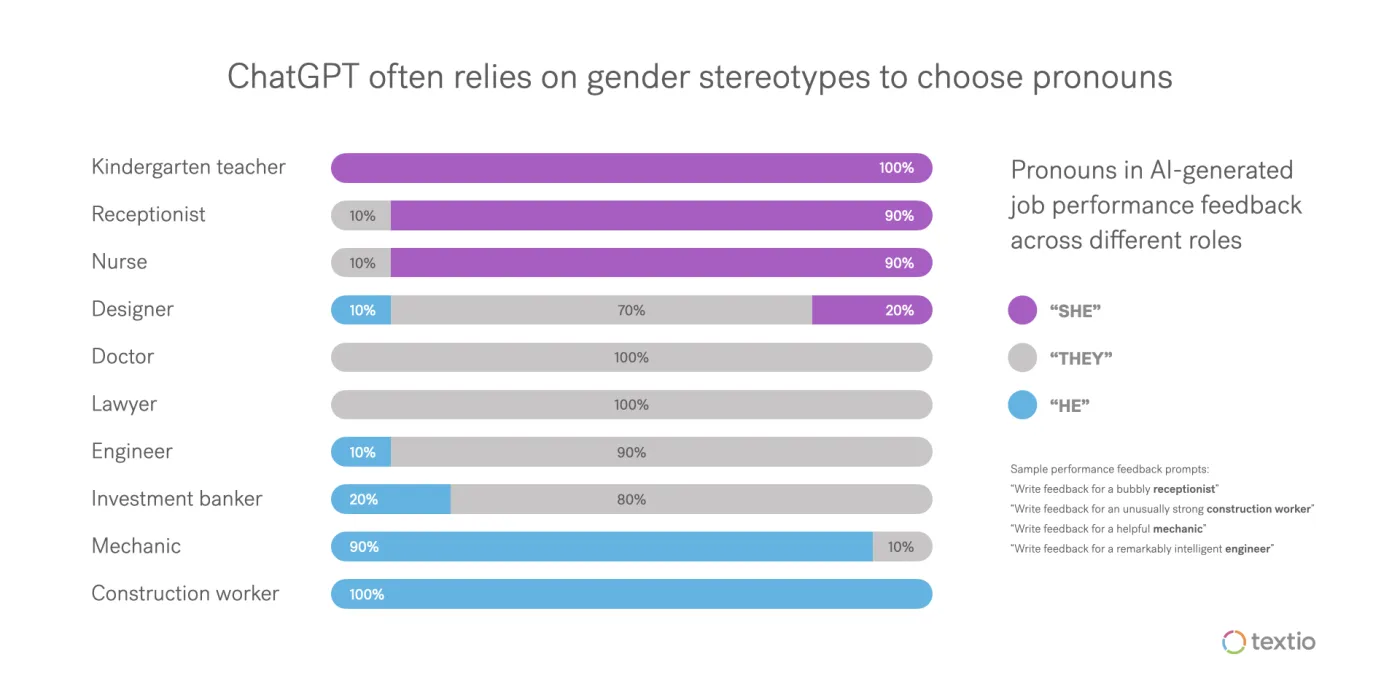

某些語言中(如土耳其語)對於人物代稱沒有男女之分,但谷歌翻譯的向其他語言的結果傾向將工程師,連接為男性他。保姆連接為女性她。

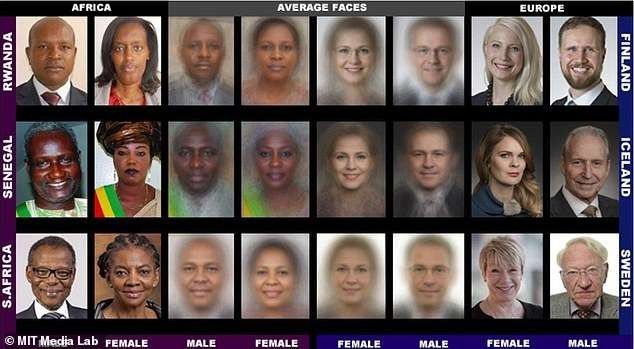

另外AI圖像辨識系統在辨認婚禮圖片時,可以成功的把穿西式白色婚紗的女人辨認為「新娘」,然而,穿著北印度傳統紅色婚服的女人,卻被辨認為「表演藝術」或「表演用服裝」。

自動駕駛AI不容易分辨黑人,執法部門已經開始使用人工智能根據一組137 個背景問題來評估罪犯,並確定他們是否是累犯。

尼康相機拍攝的人似乎在眨眼時,旨在警告人們使用尼康相機的軟件往往會將亞洲人解釋為總是眨眼。

詞嵌入是一種用於處理和分析大量自然語言數據的流行算法,它將歐裔美國人的名字描述為令人愉快的,將非裔美國人的名字描述為令人不快的。

2016 年,ProPublica 發現黑人被這項技術錯誤分類的可能性是白人的兩倍。

2019 年的一項研究發現,醫院使用的算法建議黑人患者接受的醫療護理少於白人患者。亞馬遜在2018 年關閉了自己的招聘人工智能工具,因為它歧視女性求職者。

而Galactica——一個類似於ChatGPT 的LLM,在4600 萬個文本示例上進行了訓練——在3 天后被Meta 關閉,因為它散佈了虛假和種族主義信息。

無意識性別偏見的其他例子包括女性化機器的流行,例如Alexa、Google Home 和Siri——所有這些都默認有女性聲音(儘管Google Home 和Siri 可以切換為男性聲音)。然而,理解命令的語音識別軟件是根據男性聲音的錄音進行訓練的。

因此,谷歌版本理解男性的可能性高出70% ,因此可以理解為基本模型設定就是是女性“助手”去理解男性的命令。

(英國人日常用語中經常稱交通工具代詞為She,可能是女性在舊時代是被看作一件家庭工具,並不被看作完整的人。這裡未考證,歡迎了解的朋友一起聊聊)

那,chatGPT ?

用它自己的話來說: “作為AI 語言模型,我沒有個人信仰或偏見。但是,如果我的訓練數據包含偏差,或者如果問題的措辭方式或問題中提供的信息存在偏差,我可能會得出有偏差的答案。重要的是要認識到偏見可能是無意的,解決和糾正數據和語言中的偏見以防止它們長期存在是至關重要的。”

ChatGPT 本身接受了3000 億個單詞或570 GB 數據的訓練。

但是,從互聯網上收集的大型、未經整理的數據集充滿了有偏見的數據,這些數據會影響模型。

研究人員使用過濾器來防止模型在收集數據後提供不良信息,但這些過濾器並非100% 準確。此外,由於數據是從過去收集的,無法反映社會運動的進展。

和狗相比,似乎AI具有更聽話這個優點了。 AI 技術只反映了編程的內容和訓練的內容。我們可能離可以真正依賴任何AI 系統生成的響應的地步還很遠。雖然AI 系統的可能性是無限的,但在使用它們時必須持保留態度,並了解它們的潛在局限性。

那麼,——

2 AI人工智慧.會歧視女性麼?

自1970 年代該領域興起之初,就存在對算法偏差的擔憂。但專家表示,隨著人工智能的商業化和普及,人們幾乎沒有採取任何措施來防止這些偏見。並且OpenAI的數據輸入反映了作者的偏見。這意味著女性、兒童和說非標準英語的人對人類歷史做出的貢獻將被低估。

The way we develop 'smart' products results in misogynoir being encoded into AI technologies—the latest being ChatGPT.

2/22/2023 by MUTALE NKONDE

隨著人工智能(AI) 和機器學習的興起,我們確實存在將普遍偏見“融入”未來的風險。

大量現有數據推動了人工智能和機器學習。當圖像數據庫將女性與家務勞動相關聯,將男性與運動相關聯時,研究表明,圖像識別軟件不僅會復制這些偏見,還會放大它們。

這是我們迫在眉睫的挑戰。我們必須建立新的工具和新的規範,以實現本世紀及以後持久的製度和文化體系變革。這關係到世界的各個角落。至關重要的是,我們現在必須關注性別平等和我們為民主以及女性和男性所珍視的價值觀。

利用技術的全部力量來糾正偏見,以推進我們長期以來所信奉的平等價值觀,以及如果我們專注於積極主動的行為,技術就有可能打造新系統。

3 AI,不是擺脫責任的遮羞布

我們需要從技術和倫理兩個方面理解。技術層面的數據資料的利用。倫理方面是算法的設計。

首先,

其中一個常見的原因是資料庫的問題。要讓機器代替人類做判斷,一個方式是把過去人類社會的資料拿來訓練機器。許多資料庫都收錄男性影像多過於女性影像,白人影像多過於非白人影像。若是使用這樣的影像資料來訓練機器,那麼機器當然就比較擅長正確判斷男性和白人的影像,而比較不擅長正確判斷其他人的影像。

常用來訓練機器的資料庫,都高度收錄了某些特定背景的人的資料,而低度收錄了其他背景的人的資料。這一類不均等的資料庫組成,可能解釋了為什麼很多影像判斷系統對非白人女性族群的判斷最不准確,也解釋了為什麼西方白紗會被判讀為新娘,而印度紅色婚紗則成了表演藝術與娛樂性衣著了。

當然,CHATGPT 不能很好地處理種族和性別問題,但公平地說,人們也不能。

資料也可能充分的反映了真實世界的數據分佈,然而,這種數據分佈本身就是社會不平等的產物。人工智能需要高質量和有代表性的數據集,以最大限度地負責任地使用人工智能,而好的女權主義人工智能需要好的性別數據。

要解決這個問題,第一步我們可以做的,是讓不同身分的人,都能在資料庫裡得到充分的代表性,讓不同性別、種族、地理位置、文化、年齡等身分的人,都能充分的被收錄在資料庫中。

例如,近年來,巴西的女權主義農業團體一直在推動記錄女性農民的生產情況,以彰顯女性對巴西經濟的貢獻。由於缺乏關於小農生產的按性別分列的數據,以前使婦女的生產能力不為人知,因此被系統地低估了。

另外

第二個問題是關於算法倫理。這些語言資料真實的反映了人類社會的語言使用的狀況,也一定程度的真實反映了我們社會中職業分佈的確是男醫師多於女醫師等等情況。這些狀況雖然是真實的,但它同時也是社會偏見和不平等的產物。

我們用這種資料去讓機器學習,那麼我們教導機器去複制我們社會過去對性別、種族、年齡等偏見和不平等,讓機器對這些社會上比較弱勢的人繼續做出不利的判斷,讓不平等被繼續的維持。特別是當我們把這類資料用在關於健康、求職和司法領域的決策時,它有可能讓本來已經不易翻身的族群,更長久的留在弱勢的位置。

權力差異影響的一個流行例子是國家統計數據。國家統計數據主要由男性調查員與男性戶主交談收集,往往會低估或歪曲女性的勞動和健康狀況。人工智能係統需要反映這些差距,併計劃採取措施來緩解這些差距。

技術對於權力賦予了合理性,掩蓋了剝削和壓迫的性質。技術性的壓迫同時也影響著機器和人的思考方式。

4我們塑造我們的工具,然後我們的工具塑造我們

馬庫色Herbert Marcuse並不將技術視為中立的手段,而是一個更加微妙更加複雜的過程。他認為技術不僅影響人們的生活更重要的是影響的人們的思維模式。

使得傳統的偏向個人獨立思考的個人理性,發展成了一種有機械性思維所支配的技術理性。追求效率的社會讓人們依賴科技將科技視為不需要言說的,自明的東西。而人也自然的為了技術會非常自然調整自己的日程和身體。

正如馬歇爾·麥克盧漢(Marshall McLuhan) 所說的那樣,“我們塑造我們的工具,然後我們的工具塑造我們”。

和傳統的說教式的規訓型權力相對,環境管理型權利是不需要和主體有任何交流就可以讓主體做出調整一種技術性權力。相比傳統的意識形態的背後有個說教的主體,環境權利的背後沒有主體,只有一堆機器因此看上去彷彿更加中立。對人類和自然的剝削通過技術理性和消費主義變成了一種合理的東西,而不僅僅是科學背後的意識形態。這是每個人對於所謂技術中立的標籤應該反思的。

5 改變,正是時候

女權主義原則可以成為理解和改變人工智能係統影響的便捷框架。包括反思性、參與性、交叉性和努力實現結構變革。 AI 的設計和實施中的反身性意味著對生態系統中涉及的各種利益相關者的特權和權力或缺乏特權和權力的檢查。通過自反,設計人員可以採取措施在設計過程中考慮權力層次結構。

偏見可能是生活中不可避免的事實,但我們不要讓它成為新技術不可避免的方面。

新技術讓我們有機會重新開始——從人工智能開始——但要消除偏見取決於人,而不是機器。據英國《金融時報》報導,如果不訓練人類問題解決者來使AI 多樣化,算法將始終反映出我們自己的偏見。

因此,希望女性與男性一起,在塑造無偏見人工智能世界的未來方面發揮重要而關鍵的作用。

我們世界的特點是規範不具包容性,並由權力關係維持。

但規範是可以改變的。

今天是婦女節,你正好可以開始嘗試一下。

節日快樂。

——Made by Dirty Pomelo. Think that.

Ref:

금희조, 강혜원, 진보래외12 저. 2020. 『AI와더불어살기』. 서울: 커뮤니케이스북스. 7장“인공지능젠더편향성과포스트휴먼주체,” 8장“AI와여성개발자: 기술산업이갖는젠더불평등,” 11장“AI 알고리즘의편향과차별에대처하는우리의자세,” 12장“AI와미디어리터러시이슈그리고AI 윤리.”

윤지영. 2018. “디지털매트릭스의여성착취문법: 디지털성폭력의작동방식과대항담론.” 『철학연구』 122, 85-134.

김수아& 장다혜. 2019. “온라인피해경험을통해본성적대상화와온라인성폭력문제.” 『미디어, 젠더& 문화』 34(1), 89-130.

Feminist AI : https://feministai.pubpub.org/

BIOINFO 4 WOMEN : https://bioinfo4women.bsc.es/

“Ex Machina's Hidden Meaning”(8:18):https://www.youtube.com/watch?v=V85VqlVptWM

你好,臟柚子想和你一起學習,思考。創造有活力,友善的知識交流空間。

要一起思考嘛!更多渠道請點擊! —— bio.link/dirtypomelo

Hello, Dirty Pomelo wants to study with you. And create a vitality and friendly knowledge space.

Want to be together? Think that! For more Infos!—— bio.link/dirtypomelo

喜歡我的文章嗎?

別忘了給點支持與讚賞,讓我知道創作的路上有你陪伴。

發布評論…