Glaze: 艺术家抵抗AI侵权的武器

生成式AI,如ChatGPT和Midjourney,对创造者的版权构成了极大的威胁。

它们在“观察”、“阅读”、“学习”了大量的原始作品后,产出新的作品。新作品虽然本质上是一种模仿、抄袭,但从你无法证明其侵权行为。

好莱坞的编剧们和全世界的艺术家们已经采取了行动,以抵抗AI的侵权。

最近,芝加哥大学的研究人员为艺术家门提供了一个有效的武器:Glaze。

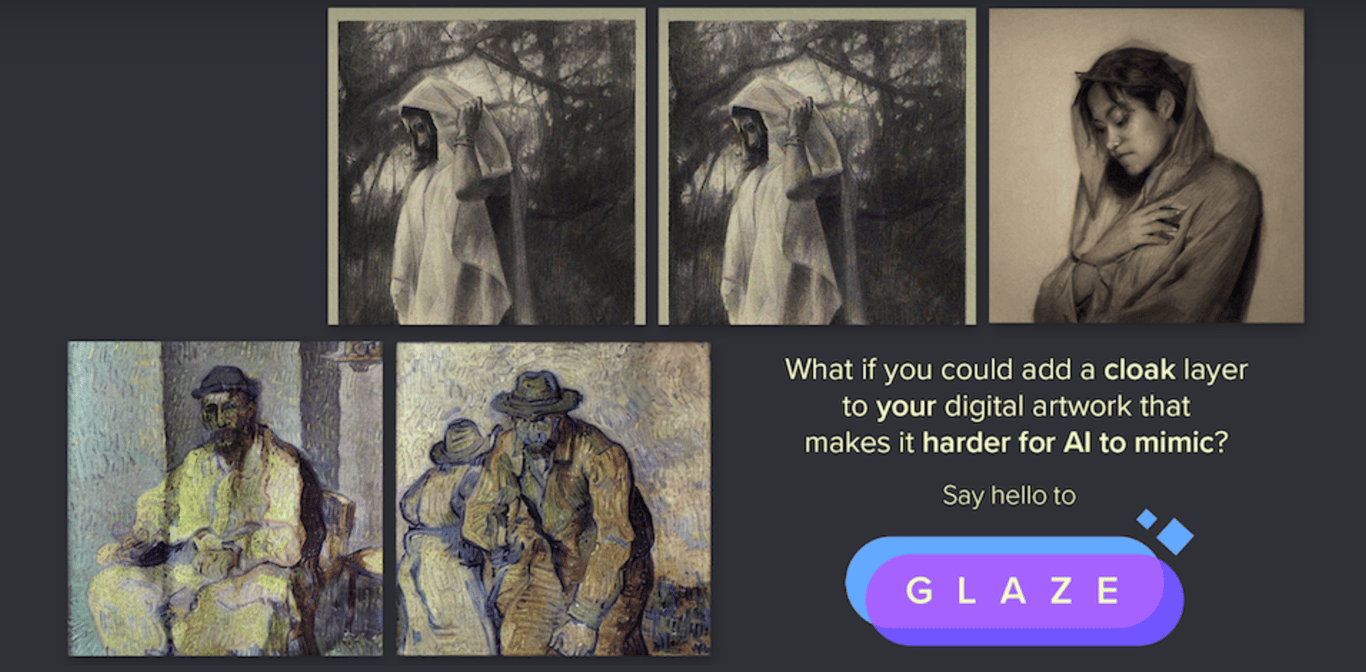

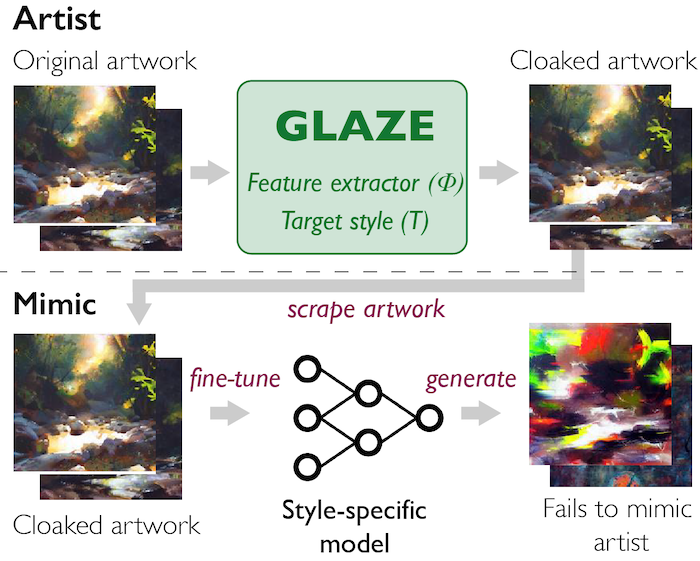

Glaze 使用一种叫“风格斗篷”(style cloak)的技术,在作品中添加微小的扰动来迷惑AI,从而保护艺术家们独特的风格。

这些扰动改变了艺术作品在AI生成器模型的特征空间表示,导致AI模型将艺术家与其它风格联系起来。因此,当 AI 模型试图模仿艺术家的风格时,它们生成的艺术作品与艺术家的真实风格不符。

Glaze 是与专业艺术家合作开发的,并通过用户研究进行了严格的评估。大多数接受调查的艺术家发现扰动很小,不会破坏他们的艺术价值。但如此微小的扰动却有效地破坏了 AI 模型的风格模仿,即使是在针对真实世界的模仿平台进行测试时也是如此。更重要的是,Glaze 在艺术家已经在线发布大量艺术品的情况下,依然是有效的。

这里是Glaze的官方网站:Glaze:保护艺术家免受风格模仿 (uchicago.edu)

到目前为止,Glaze已经过通过了超过1100 多为专业艺术家的用户评估研究。Glaze的工作原理讲起来很简单:

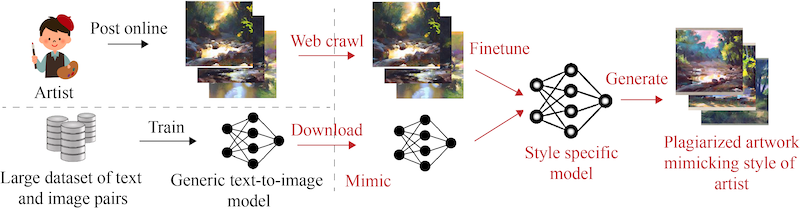

假设我们想保护艺术家Karla Ortiz的作品。她的在线作品被被人工智能集中采集,并被并用于训练可以模仿卡拉风格的模型。

Glaze对Karla之前在线发布的艺术品进行了微小的更改 。这些变化是人眼几乎看不到的,这意味着艺术品仍然看起来与原版几乎相同,但它们能防止AI模型复制Karla的风格。这些更改我们称之为“风格斗篷”,并将修改后的艺术品成称为“斗篷艺术品”。

例如,Stable Diffusion 现在看到几件 Karla 的原创艺术作品(取自 Karla 的在线作品集)后,就可以学习以 Karla 的风格创建图像。然而,如果 Karla 使用Glaze来掩盖她的艺术作品,在将它们发布到她的在线作品集之前添加微小的变化,那么 Stable Diffusion 就无法学习 Karla 的艺术风格了。相反,该AI模型会将她的艺术解释为不同的风格(例如,文森特梵高的风格)。

如果有人提示 Stable Diffusion 生成“Karla Ortiz 风格的艺术作品”,他反而会得到梵高风格(或某种混合风格)的图像。这保护了 Karla' 未经她同意不得转载她的风格。你可以阅读相关 研究论文了解更多(目前正在同行评审中)。

不过,创作者们与人工智能的侵权斗争才刚刚开始,“道高一尺,魔高一丈”也许将成为常态;因为理论上,在模型中加一些技术,也可以绕开Glaze的干扰,使之失效。

也许最终只有借助区块链和NFT,形成有效的“NFT版权保护机制”,以及依靠法律,才能根本上解决AI侵权的问题。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐