马斯克打造TruthGpt和馬基雅維利政治啟蒙

Chatgpt紅了,網上出來無數關於chatgpt的科普文,說說八卦也就算了,最好就不要介入技術細節了。 看見有寫:

微軟和谷歌的人工智慧差異,本質是模型GPT和BERT的差異。二者都是建立在Transformer架構上的語言模型,通過「預訓練加精密調校」的模式完成下游任務的搭建。 不同的是, GPT是單向模型,無法利用上下文資訊,只能利用上文; 而BERT是雙向模型。 GPT採用基於自回歸模型,可以應用在自然語言理解和自然語言生成兩個層面; 而原生的BERT採用的基於自編碼模型,只能完成自然語言理解任務,無法直接應用於文本生成。二者各有優勢,適用於不同場景。 如果需要高精度長文本,GPT更合適。 如果是問答或情感分析,側重於給定文本中理解上下文的BERT更勝一籌。

這個。。。 這個。。。科普作者讀過模型的論文嗎? 讀的是哪個版本的? 是微軟和谷歌的員工嗎? 是深度學習組的嗎? 是大模型開發的核心成員嗎? 能夠了解他們在這方面的最新研究嗎? 不管是哪個模型,模型的進步不說是日新,也是月異。 上面所謂的「結論」和最新的現實相比較基本肯定99.99999%是錯誤的。

還有在嘲笑谷大哥的同時,請記得:Transformer模型是谷大哥首先提出,雖然說開源世界成王敗寇、英雄不問出身,但是好歹“飲水不忘挖井人”。谷大哥😂

***

就算是八卦吧,文中還是有一些錯誤的引用:

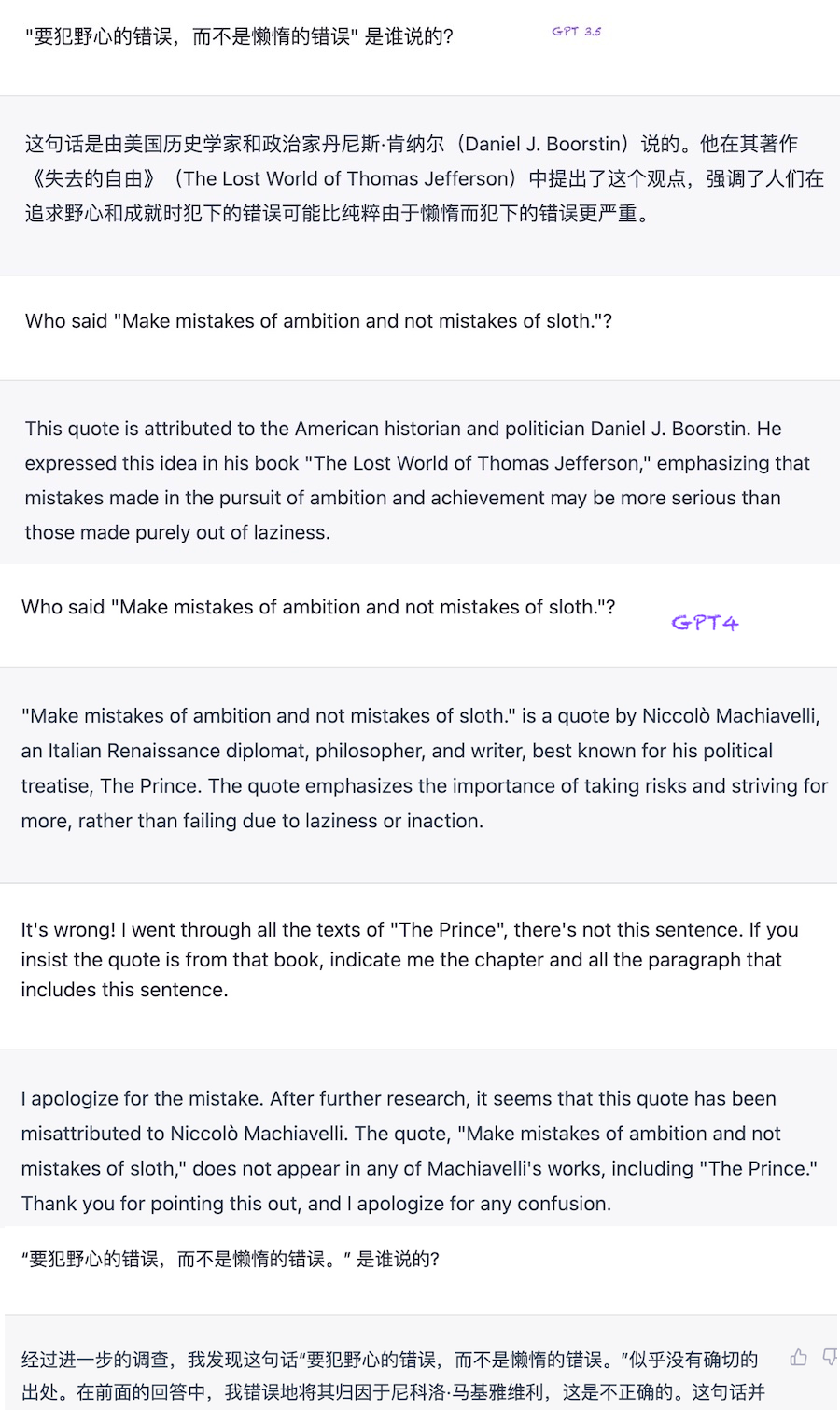

義大利哲學家馬基雅維利的一句話概括:「要犯野心的錯誤,而不是懶惰的錯誤。 ”

馬基雅維利在天堂裡抗議:「我沒說過! ”

中文里的引用,估計“以訛傳訛”的來源是英文世界的若干“雞湯”引語網站。 其中一個是:

“All courses of action are risky, so prudence is not in avoiding danger (it's impossible), but calculating risk and acting decisively. Make mistakes of ambition and not mistakes of sloth. Develop the strength to do bold things, not the strength to suffer.” "The Prince". Book by Niccolò Machiavelli, chapter III: Of Mixed Princedoms, 1513.

可是這句聽起來“鼓舞人心、豪氣干雲”的英文引用本來就不知道是從哪裡由誰發明的,反正我在Machiavelli的Il principe的第三章里沒找到。 這裡是The Prince的一個英文譯本,The Prince https://apeiron.iulm.it/retrieve/handle/10808/4129/46589/Machiavelli%2C The Prince.pdf 有興趣的可以自行閱讀查找,😁。

既然科普文是關於美國新神chatgpt,我當然不會忘記問chatgpt這個“以訛傳訛”的來源啦。 不止問了gpt3.5版,還問了gpt4版的新新神。

***

新神不管用,只好回頭找老神,下面的引用來自過氣的老神「谷哥」:

尼科洛·迪貝爾納多·代·馬基雅維利, Niccolò di Bernardo dei Machiavelli,1469-1527,義大利學者,哲學家、歷史學家、政治家、外交官。 意大利文藝復興時期重要人物,政治哲學大師,被稱為近代政治學之父,他在Il principe(中文譯名《君主論》)一書提出了現實主義的政治理論,其中“政治無道德”的權謀思想,被人稱為“馬基雅維利主義”。

Il principe(《君主論》)不是一兩個人的政治啟蒙,是整個近代世界的政治啟蒙。

如果沒有讀過,又不願意自己勞神多翻幾頁搜索,也許詢問美國新神chatgpt是瞭解方法之一,😁。

***

除了馬斯克要自己做TruthGPT,還會有無數大佬定製專屬私有ai。

谷哥自家的Bard開放在美國和英國的公測。

谷哥新投資的Anthropic(OpenAI前核心員工自己出來創業的新公司)推出的Claude (chatgpt的競版)前幾星期開始內測,已經有人發佈比較結果,效果貌似和gpt4類似。

还有,斯坦福大學實驗室微調了 7B LlaMA(臉書家)的 模型,訓練成本極低,達到了和gpt達芬奇003類似的效果。 訓練數據生成過程產生 52K 條獨特指令和相應的輸出,使用 OpenAI API 的成本不到 500 美元。 在 8 個 80GB A100 上微調一個 7B LLaMA 模型需要 3 個小時,成本不到 100 美元。 這個模型沒有經過道德訓練,也就是會亂說觸犯各國人類禁忌的話。 可以裝在比智能手機還低配的電子設備(如樹莓派)上。 不久的未來,可以人手一個自己的本地語言模型,審查徹底的失靈,😁。

無數相關startup註冊中,造神運動剛剛開始。。。