📝📝:音樂哪裡是用聽的?

從上述兩個版本的《The Sound of Silence》可以發現 Simon & Garfunkel 的紐約中央公園側錄的影帶(1981)並沒有這麼強烈的鏡頭語言,或者你可以說,畫面看起來挺單調且無聊,只是透過鏡頭記錄演唱會。然而,在王晰、李琦、鞠红川,三人所演唱的版本中,畫面的飽和度、畫質都比 Simon & Garfunkel 的側錄高出許多。當然,也多了許多以視覺為重的鏡頭語言。

從畫面一開始鏡頭由遠處開始逐漸向舞台中央拉近,接連兩個蒙太奇帶出背後的演奏團隊,最後三位歌手以淡入(fade in)粉墨登場;其中,不乏出現同一位歌手以不同角度拍攝剪接,以淡入與淡出(fade in & fade out)拼接成演唱片段。

這些只是出現在主角的鏡頭,該片段同時也有分配鏡頭給場外的觀眾。從 0:47 開始,畫面開始捕捉到後台歌手聽得如痴如醉的神情,甚至露出驚嘆裡夾雜佩服的眼神。

試想一個問題就好:這樣的畫面細膩度是如何可能的?

從媒介的角度切入,也許能發現箇中的原理。

同樣是聽音樂,在現場聽跟在網路上聽有什麼不一樣嗎?我們首先最能察覺到的便是場域的不同。在現場聽音樂極度容易受到空間的牽製,如同管絃樂就是必須在音樂廳內演奏,若是搬出室外,樂曲演奏的震撼度反而會因為空間的開放性而下降。然而,同樣的樂曲若是搬到網路上,空間的臨場感反而因此消失了,只剩下電腦的外接音響或是手機的藍芽耳機。換言之,網路無法複製音樂廳這個場域的空間感,不過,網路能做到的反而是鏡頭語言的疊加。

事實上,從音樂廳過渡到網路,音樂的內容從聽覺主導走向視覺主導。音樂就是在聽覺過渡到視覺的環節上,讓音樂本身不只用耳朵聽還要用眼睛看。那麼,這樣的差異又是如何可能的?我認為導演吳念真給出了精湛的回答

眼睛沒有特寫,鏡頭才有特寫。

╴

讓我們想像一件事:

現在你正坐在台下,前台是你最喜歡的歌手,你可以怎麼做讓自己看得更清楚或聽得更清楚呢?

很簡單,站起來靠近台前就好了。可是,為甚麼你會想這麼做呢?在移動的過程中可以發現,為了讓自己更接近台前,身體的移動是必然會發生的。因為我們的眼睛和耳朵都是鑲嵌在身體上,想要讓視覺和聽覺獲得更好的體驗(特寫),只好移動這具載體,也就是我們的身體。因此,在移動的過程中也產生了參與感。

但是,對於鏡頭而言卻不是如此運作。為了捕捉最好的畫面和音質,錄影和收音經常是分開運作的。以上述歌手的例子來說,你可以想像,自己仍坐在原地;但是眼睛和耳朵雙雙脫離了你的身體,去幫你找到最佳的閱聽距離;在分離的過程中,我們可以發現原先身體移動所帶來的參與感消失了,轉而由攝影鏡頭、錄音設備代勞。因此,我們不難想像,若是一段從頭到尾都沒有剪輯的錄像,沒要多久就會讓人覺得無趣,彷彿身體欲求的參與感無法藉由鏡頭來達成。而最常大量調和視覺和聽覺的媒介便是電影。

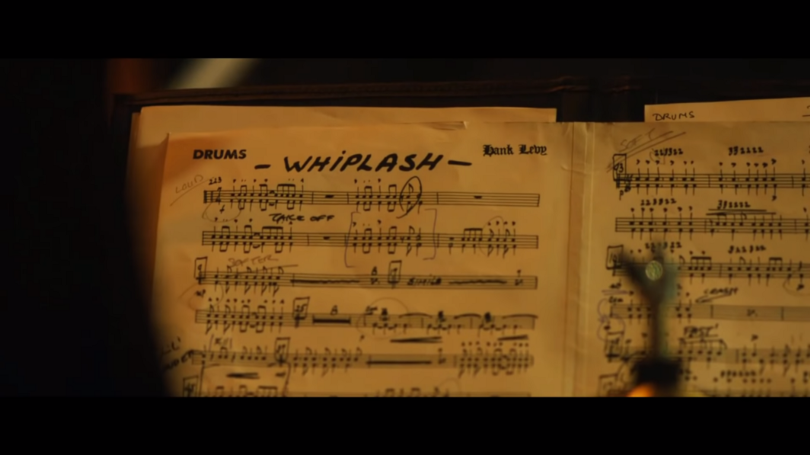

以 2014 的電影《進擊的鼓手》(Whiplash)為例。這一部同樣也是音樂為主題的電影,大量使用畫面剪接、局部特寫來呈現演奏時的緊張與沉浸。

《進擊的鼓手》高度使用鏡頭語言的疊加,Zoom in/Zoom out(鏡頭的焦距縮放); Dolly in/Dolly out(機位的軌道移動); 近景、特寫、大特寫的交錯使用。透過鏡頭反而能在音樂裡創造視覺的刺激,讓電影中所有演奏的片段成了視覺和聽覺上的雙重饗宴。同樣的技術也被大量應用在網路上的音樂 MV 裡,如:韓劇《機智醫生生活》的演員翻唱 It’s my life 的影片可以窺見《進擊的鼓手》的鏡頭應用。