📝📝:堪稱博士生等級的 OpenAI o1 將會稱霸 AI 市場?| OpenAI:與過往的模型相比,o1 至少有三大優勢

自 2022 推出 ChatGPT 3.5 後,OpenAI 便開啟了全球的人工智能元年,後繼也推出了兼具處理文、圖、音、影功能的 4o 以及 4o mini。最近,OpenAI 挾著更強大的新模型襲來—— o1 以及 o1 mini。目前僅開放給訂閱 GPT+ 的用戶試用。

o1 堪稱有著人類博士生的推理能力,對於科學、數理有更高的應對技巧。o1 以及 o1 mini 模型具有一些顯著的特色和優勢,讓最新的模型在許多方面超越了之前的 4o 以及 4o mini。

本文整理目前 o1 以及 o1 mini 的三大優勢、解答一些常見的疑問(思維鏈是什麼?RLHF 如何運作?)。

o1 是什麼?為什麼可以如此強大?

依目前已釋出的消息,OpenAI 的 o1 模型之所以如此提升,主要是因為 o1 模型採用了多種先進的技術和方法。主要有兩種技術是最為關鍵的:內部思維鏈技術、基於人類回饋的強化學習

— — —

‧

內部思維鏈技術

o1 模型使用了「內部思維鏈」(chain of thought)的技術,o1 模型在給出答案前,模型會進行多層次的推理過程。

湯森路透公司(Thomson Reuters Corporation)創新發展部主席 Pablo Arredondo 認為這是一次 AI 的重大突破,「雖然產出的所需時間較其他模型長,但是這樣的推理方法是其他模型不曾用過的。」

現任 Open AI 的研究員 Jason Wei 為 o1 模型的開發者之一,這一次的模型之所以導入內部思維鏈,是來源於他在 2021 年的一份研究《Chain-of-thought prompting elicits reasoning in language models》

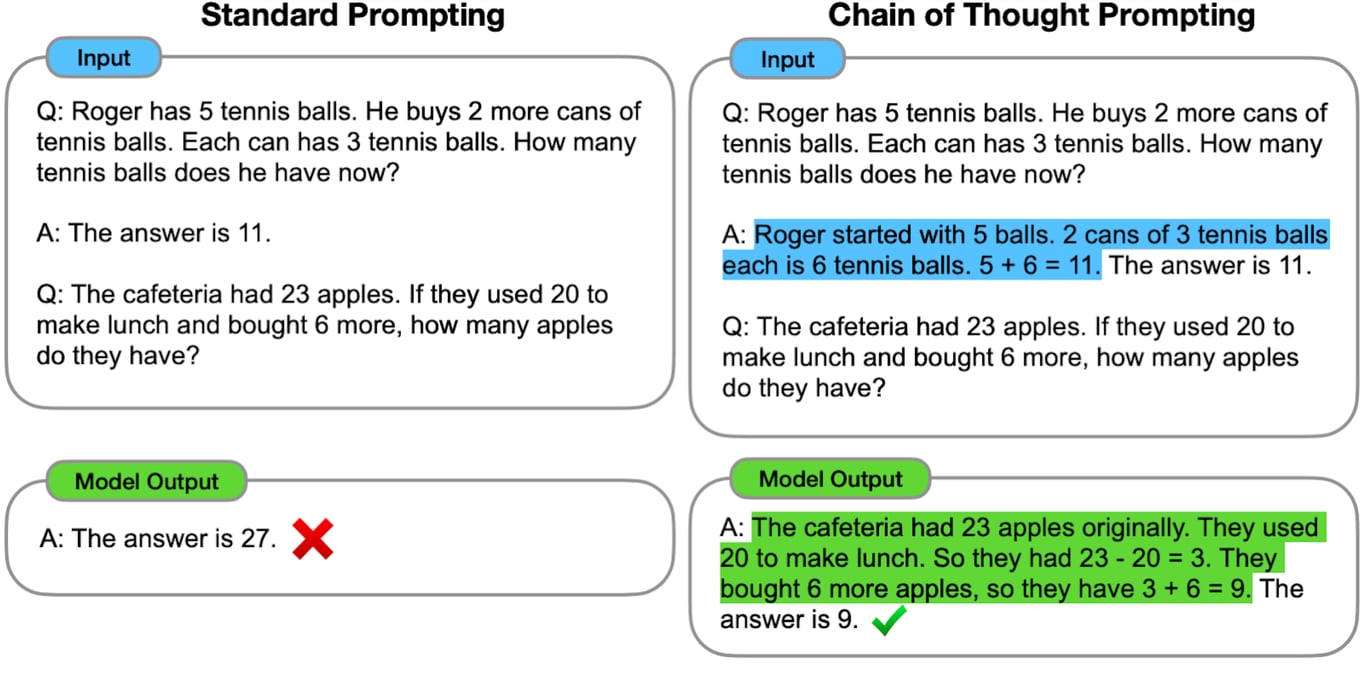

Jason Wei 發現,比起使用標準的題詞技巧(standard prompting),用思維鏈提詞(chain of thought prompting),反而可以讓大型語言模型推理得更好,特別適用在需要數字計算的領域或工作。

這也是為什麼 o1 模型需要較長的時間才能產出,當人們對模型提問後,其內部需要時間拆解步驟。Jason Wei 以一個明確的案例,分別呈現了標準題詞與思維鏈提詞的不同產出。上圖同樣都是詢問:23-20+6=?

標準提詞:27。(錯誤)

思維鏈提詞:23 - 20 = 3。接著,3 + 6 = 9。(正確)

目前 OpenAI 並未詳細說明思維鏈在 o1 模型如何進行,可以確認的是,思維鏈試圖模仿人類的思考過程,先深入思考、分解問題步驟,然後再逐步推導出答案。

— — —

‧

基於人類回饋的強化學習

o1 模型結合了基於人類回饋的強化學習(Reinforcement Learning with Human Feedback, RLHF)。

這種方法主要蒐集人類的回饋(意見)數據來優化模型的學習過程,使模型能夠更好地理解和回應人類的需求。換言之,正是讓大型語言模型不只模仿結果,也模仿、學習推理的過程。

OpenAI 在宣布新模型的文章中表示:

「我們用不同的方式訓練模型,在做出反應之前花更多時間思考問題,就像人類一樣解決問題。」

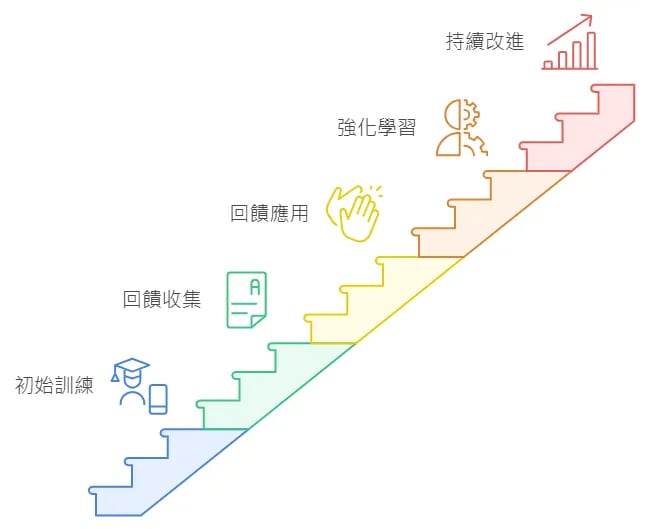

RLHF 架構下的模型至少會有以下幾個學習步驟:

初始訓練:o1 模型會先學習大量的書本和網路上的知識,了解基本的知識點和回答方式。

人類回饋收集:當學生使用這個應用程式時,有些回答會被送到老師或專家手中,他們會根據回答的準確性和有用性進行評分。

回饋應用:這些評分會告訴模型哪些回答是好的,哪些需要改進。

強化學習:o1 模型會根據這些反饋進行學習,改進模型的回答方式。比如:如果模型的回答不夠詳細,會學習提供更多細節。

持續改進:隨著時間的推移,模型會不斷接收新的反饋並進行調整,變得越來越聰明,能夠更好地幫助學生。

假設一位學生問:「什麼是光合作用?」

學習助手可能會初步回答:

「植物利用陽光製造食物的過程。」

如果這個回答被老師(人類)評為不夠詳細,模型會學習改進。下一次,模型可能會回答:

「光合作用是植物利用陽光、二氧化碳和水製造氧氣,以及轉化成為葡萄糖(Glucose)的過程。」

過往的模型的回答相當於「睜眼說瞎話」,因為在 o1 之前的模型並不具備拆解步驟的能力,也不具備反思(先不論反思一詞的哲學意義為何)的能力只注重輸出的結果「看起來」合理即可,但當前的 o1 模型修正了唬爛的出錯率。

OpenAI 也強調,導入思維鏈的培訓,o1 模型學會優化自己的思考過程,嘗試不同的策略,並認識到自己的錯誤。可以說,o1 模型不只是習得推理,也學會事實查核(fact-check)能力,可以大幅降低看到黑影就開槍的唐突。

o1 的三大優勢,對上 4o 誰更勝一籌?

強大的推理能力

o1 模型在推理能力上有顯著提升,能夠處理複雜的問題並提供深入的分析。例如,在數學和科學領域,o1 模型能夠解決高難度的問題,並且在代碼處理中表現卓越。文後有測試,o1 生成的計畫書也更加完整周全。

據 OpenAI 所言 ,在國際數學奧林匹克競賽 (International Mathematical Olympiad, IMO) 的資格考試中,GPT-4o 僅解決了 13% 的問題,而 o1 模型則為 83%。o1 模型的寫程式能力在 Codeforces(一個舉辦程式設計競賽的國際型網站)比賽中達到了總排名的前 11 %。

— — —

‧

思維鏈生成機制

o1 模型能夠生成內部的思維鏈,相當於人類大腦的神經網絡(neural network)這讓 o1 在推理過程中進行多階段的分析,得出更準確的結論。

思維鏈的推理機制,特別適用在需要深入分析的任務,例如:醫療保健研究人員可以使用 o1 模型來標記細胞測序數據,物理學家可以使用 o1 模型來生成量子光學所需的複雜數學公式。

— — —

‧

多模態功能

OpenAI 未來計劃支援多模態與跨媒介的功能,o1 模型將能夠處理不僅僅是文本,還包括圖像和其他數據形式。例如:o1 模型可以同時分析文本和圖像,提供比 4o 更全面的解決方案。

目前 OpenAI 旨在開發推理能力更強大的「草莓計畫」(Strawberry Project)可以說,o1 模型是草莓計畫重要成果之一,也是未來開發更高階的模型(如:GPT-5)的試金石。

— — —

‧

據悉,目前只有 ChatGPT+、Team 方案的會員,才能使用 o1-preview 和處理速度較快的小模型 o1-mini。9 月 17 日官方則更新了目前的使用限制:每週可傳送 50 則訊息給 o1-preview、o1-mini 則為每天 50 則訊息。接下來 OpenAI 會陸續開放 Enterprise 和 Edu 方案的會員使用。o1 像理科生、4o 像文科生

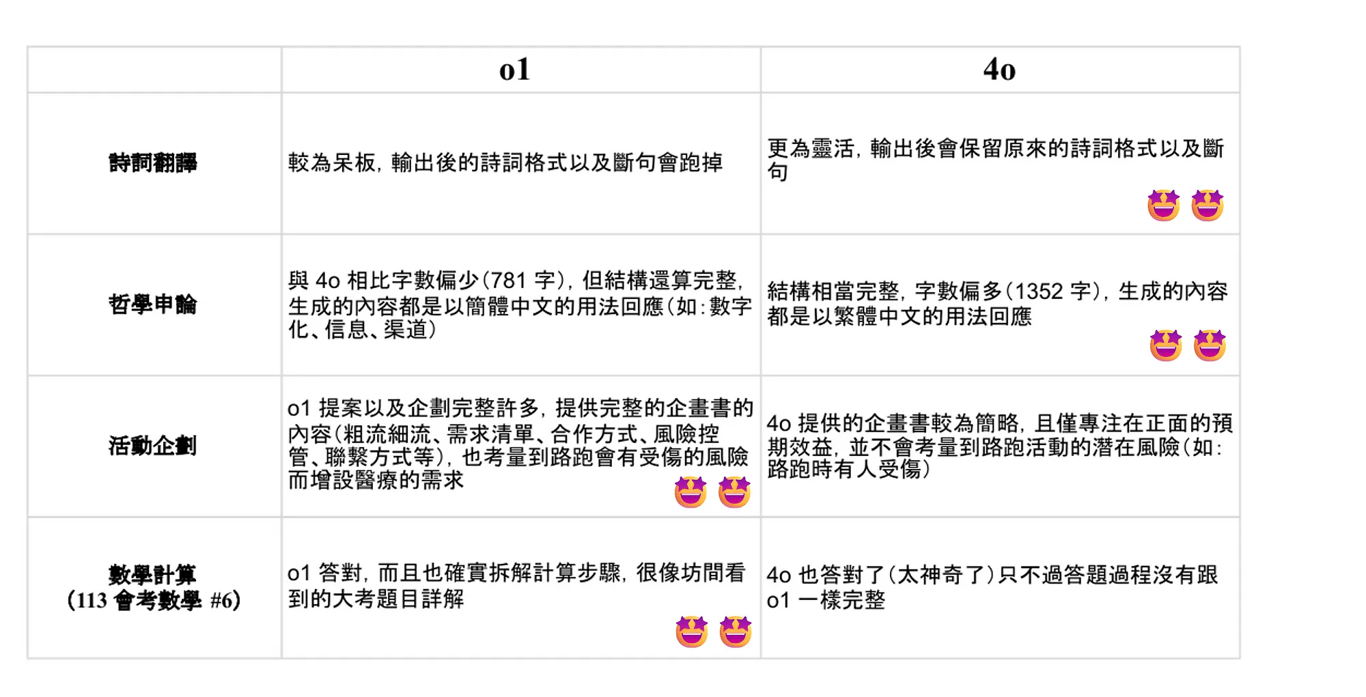

至於大家引頸期盼 o1、4o 哪個比較好用?我分幾個面向測試了兩個不同的模型,製作了一個簡單的表格,在四個不同領域的表現,分別是:詩詞翻譯、哲學申論、活動企劃,和數學計算。

總結來說,各有優劣。o1 確實如官方所說,更擅長推理以及計算,是個妥妥的理科生。而 4o 在翻譯以及文字表述的產出較為擅長,生成的回應也較回口語且人性化,相當於一個文科生。因此,需要看使用的需求,再決定哪個模型較能勝任,並沒有哪個是絕對的好。

詩詞翻譯|翻譯美國詩人愛倫坡的 A Dream Within a Dream

o1:較為呆板,輸出後的詩詞格式以及斷句會跑掉。

4o:更為靈活,輸出後保留原來的詩詞格式及斷句。

哲學申論|解釋以及應用哲學家柏拉圖提出的《洞穴預言》

o1:字數相對少(781字),但結構還算完整,內容皆以簡體中文的用法回應(如:數字化、信息、渠道)。

4o:字數相對多(1352字),結構更完整,內容多以繁體中文的用法回應。偶有簡體中文。

活動企劃|策劃一檔 200 人的路跑活動並向運動品牌提案

o1:企劃書完整,包含流程、需求清單、合作方式、風險控管等,更讓人驚豔的是,o1 考慮到路跑活動的風險,並增加醫療設備需求。

4o:企劃書較為簡略,僅專注於正面預期效益,未考慮戶外活動的潛在風險(如:跑者受傷)。

數學計算|以 113 年國中教育會考數學科第六題作為題目

o1:答對且步驟完整,詳細解釋題目(前提、方向)的每個步驟,很像坊間看到的大考題目詳解。

4o:令人驚訝的是 4o 也答對了,但答題過程不如 o1 完整。我猜測思維鍊的技術應該也有應用到 4o 上了。

結語|速度飛快的模仿遊戲

目前推出的 o1 模型,在我看來,比較像是 GPT-5 或是草莓計畫的一個階段性產品,OpenAI 試圖說服大眾:在這場全球大型語言模型競賽上,我才有資本研發跟創新。

但不可否認的是,OpenAI 確實有資金和創新的優勢,不僅在全球收穫各家創投的資金,模型更新速度也高過市面上其他的模型。近期,OpenAI 又再度推出「進階語音模式」(Advanced Voice Mode),讓 GPT 可以自訂指令、記憶功能、五種新聲音,甚至讓使用者隨時打斷也無妨。

擁有語言對談功能的 GPT-4o 首次於 2024 年 5 月 13 日發布,當時的 OpenAI 技術長 Greg Brockman 在公開直播展示,GPT-4o 流暢的對談與表達讓世人震驚 AI 的發展,僅僅過了四個月,OpenAI 又再度推出了進階語音模式。

目前只有 ChatGPT+、Team 方案的會員,才能使用 o1-preview 和處理速度較快的小模型 o1-mini。換句話說,每個月須要花費約新台幣 600 元(20 美元)才能使用 o1 模型,如果你對於我如何用不到一半的價格訂閱 ChatGPT+ 感到好奇,可以點選下面的連結。