《AI制造商没说的秘密》:一场几近成功的追寻,是否会走向失控?

自AlphaGo在2016 打败棋王李世乭以来,人工智慧、深度学习等字眼相信大家早已不陌生。面对这个AI 急速发展的时代,你对这「智慧」了解有多少呢?推荐这本《AI制造商没说的秘密》,带你一探AI的崛起之路,思索「它」的可能与危险。

作者凯德.梅兹是《纽约时报》科技记者,长期深耕人工智慧、自动驾驶、机器人等领域。书中他从「人」的角度出发,为读者带来一场精彩的AI演进简史。取材严谨,叙事流畅,读来畅快又引人深思。

我的构想不是写此一科技,而是研发此一科技的人。

【AI的起源】

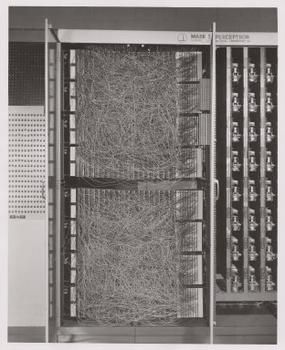

1958 年, 29 岁的康乃尔教授 法兰克.罗森布拉特与他的海军同伴展示了一个名为「 感知器」的机器。罗森布拉特将两种卡片塞入机器,一张左边有方形记号,一张在右边。起先机器无法辨别差异,但在50 张卡片后,它开始能分辨卡片上的记号,左边、右边、右边……,作答精确无误。

罗森布拉特表示,这是套模仿「人类大脑」的数学系统。在未来,「它」将可以学会辨识手写字体、口语指令,甚至是人脸。据《纽约时报》报导,海军官员对于是否要将其称为「机器」有些拿捏不定,因为它太像「人类」,只差没有生命。

海军设计出能够思考的科学怪人

感知器是最早的「神经网路」之一,可说是AI(人工智慧)的起源。罗森布拉特预言现在看来精准的骇人,而他也被称作是深度学习之父。不过他在43岁时意外过世,继续推动AI走到今天的,是一群神经网路狂热者……

【AI黑手党】

罗森布拉特的目标是打造能像人脑般「自我学习」的机器。科学家称这样的概念为「连结主义」,因为它需要大量「神经网路」连结运算。与之相对的是「符号主义」,其步标是打造能根据人类指示,在不同状况下做出不同反应的机器。

现在神经网路已然是人工智慧显学,但这领域一度面临寒冬。过去很长的一段时间,神经网路发展极度迟缓,不但被政府大删预算,大多数科学家也都转向符号主义的怀抱。那段时间,研究人员为让论文被接受,甚至故意用像「函式近似」或「非线性回归」等名词取代「神经网路」。

即便憋屈,但仍有一搓人对神经网路的充满信仰。这领域的关键人物有三人:辛顿、杨立昆与班吉欧。整本书内容几乎都环绕在这「三巨头」身上。而他们也在2019 年获得电脑界诺贝尔奖的「 图灵奖」。

当然神经网路的成功,绝非只靠这三人,还有太多太多人的共同努力。光书中提到的就有数十人。在阅读的过程中,我感受到这群人对「梦想」的狂热。如同《失控的轰炸》中那群相信精准轰炸的轰炸机黑手党般,这些人同样抱着宗派式的狂热,对神经网路一往情深。开放人工智慧实验室领导人阿尔特曼形容得传神:

自信是一股非常强大的力量,我所认识最成功的人士都相信自己,坚信不移,甚至已到幻想的地步。

随着神经网路、深度学习的概念被认可,这些狂热终于转成真金白银。各大科技公司都捧着高薪求才。书中提到,即便是刚出校门的菜鸟博士,年薪都高达50 万镁。看得我不免感叹入错行(笑)。敝司在美国给新人博的价码连20 万镁都不到,根本云泥之别……

书中描述各种疯狂抢才大战,斗智斗力可说相当精彩。最后谷歌抢到了辛顿,而脸书则拥有杨立昆,而他们的徒子徒孙们也都进入各大公司,一展长才。

【AI的强大可能】

话说回来,大家常听到的「深度学习」到底是什么?它是一种「多层」神经网路。不像感知器只有单层,这方式可以藉由将讯息传输给下一层,学习更复杂的事物。

比如给系统看一张狗的照片,第一层会分析像素颜色(黑、白、棕……);接着将结果传给第二层,第二层进一步分析像素模式(直线、弧线……);第三层会继续检视这些像素的其他模式,以此类推……最终就能辨识出一只狗的形象。

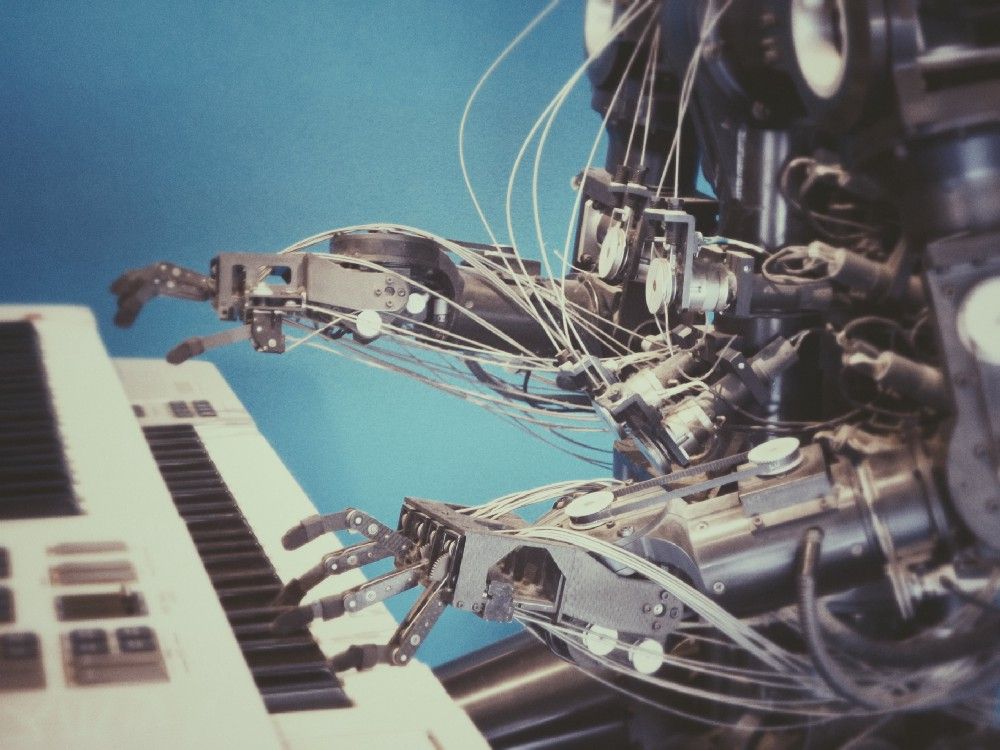

当然要实现这想法并没那么简单,光辨识出一只狗,就花了科学家大把时间。不过在这群狂热者的奋战下,深度学习开始在各领域攻略城池。现在的深度学习系统已能精准判读语音;稳定辨识手写字体;顺利在不同语言间转译;甚至还能作曲、 作画。而最广为人知的例子,或许是AlphaGo击败前世界围棋棋王李世乭。

书中有个例子让我印象很深。辛顿的学生乔治.达尔参加由默克药厂发起一项竞赛。这竞赛想探讨的是一种称作「定量构效关系」的药物研发技术。但达尔压根不晓得这是什么,却依然用深度学习系统获得优胜。如辛顿说的:「乔治横扫整个领域,却还不知它叫什么。」

这让我想到《反脆弱》。深度学习系统似乎就实践其中提到,不用了解「理论」,而是藉由反覆试误、调整找到更佳解的模式。人工智慧用强大的自我学习能力,找到人类不能企及的新可能。谷歌前执行长史密特说得巧:

在科学与生物学中,存在许多人类看不到的模式,而在辨识出来后,可以帮助我们开发出更好的药物与解决方案。

看起来很美好,但这一切并不是没有隐忧……

【AI的问题? 】

从众人看衰,到攻无不克,AI的未来看似一切光明。但随着人工智慧逐渐强大,许多问题也浮上台面。

〔隐私疑虑〕

辛顿的学生苏茨克曾说,神经网路的优势是你只要喂它资料,它就可以自我学习行为。

但问题是你要先有「资料」。

深度心智的创办人苏莱曼曾打算透过进行一项计画,透过让AI 分析病患医疗纪录(血检、生命迹象、过去医疗史等),预测「急性肾损伤」。急性肾损伤发生率高(每5 个住院病人就有1 人),甚至可能会丧命,但只要及早发现就能治愈。

原本深度心智已经与皇家医院国民保健基金会信托金签约,获取160 万名病患的资料。但在《新科学人》杂志揭露此合作案后,马上就引发众人对隐私权遭侵犯的恐惧。最终这项合作被英国主管当局判定违法。

不管你希望深度学习攻克哪个领域,都要有大量的资料供它自我训练。但当其牵扯到个人隐私时,状况就变得相当棘手。

〔训练偏误〕

另一个问题是,深度学习的训练可能会产生「偏差」。

书中有个骇人的例子。谷歌所提供的智能辨识系统竟误将非裔美国人识别为「大猩猩」。因为当初在建立辨识系统时,工程师多为白人男性,而他们挑选的资料也几乎都是白人,这导致系统对有色人种判断力不足。

除了喂养的资料可能会有偏差,还有一个更难解的问题:训练标准。

随着社群发展,假新闻与仇恨言论得到前所未有的放大。脸书创办人祖克柏就声称能透过人工智慧,撤除这些「有问题」的资讯。问题是连人类都很难对什么是假新闻,什么是仇恨言论达成共识,又要怎么训练机器去判读呢?

不若围棋或星海等游戏是封闭环境,有清楚规则与判定胜利的标准,现实世界没有人会打分数。如电脑科学家乔艾.布兰维尼说的:

我们该以由谁的决定进步的意义?有该以何种标准决定进步?

我想,这问题恐怕永远都难有解答。

〔误用危机〕

更糟的是AI 被用到坏的地方。如三巨头之一的班吉欧说的:

我们的工具可以使之为善,也可以使之为恶。

对于能将AI应用在哪些领域一直都存在争议。如Deepfake 强大的换脸功能,就成了许多女性的恶梦。 《纽约时报》也曾报导中国政府利用人脸识别,追踪与控制维吾尔人。如作者所言:

深度学习创造出一种力量,即便当初的开发者也无法完全控制。

无怪伊隆·马斯克会说人工智慧可能毁了人类……而解方或许如深度心智创办人之一的 苏莱曼所说的:

我们在建立科技之前,必须审慎思考此一科技会如何遭到误用的问题,还有如何将其至于监管之下的问题。

像当初深度心智在出售公司给谷歌的合约中,就订下两个条件:

- 禁止将深度心智的任何科技应用在军事目的。

- 成立独立伦理委员监督人工智慧科技使用情况。

事实上他们当初决定将公司卖给谷歌而非脸书,原因就在于祖克柏并不认同他们对人工智慧可能造成的道德疑虑,拒绝成立监督委员会。

另外,更多元的参与或许也会是解方。如美国计算机科学家蒂姆尼特.盖布鲁说的:

如果许多人被排除在创造人工智慧的过程之外,此一科技仅会让少数人获利,却会对无数人造成伤害。

【后记:围棋的那点小事】

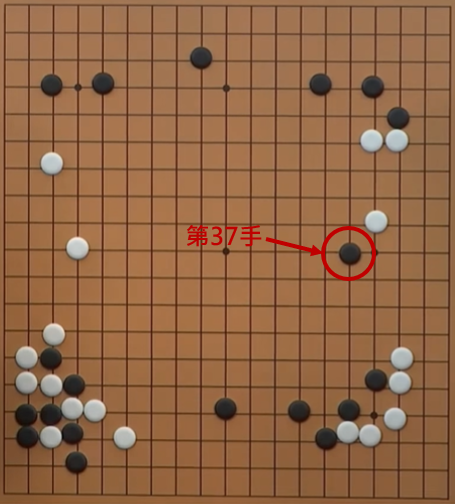

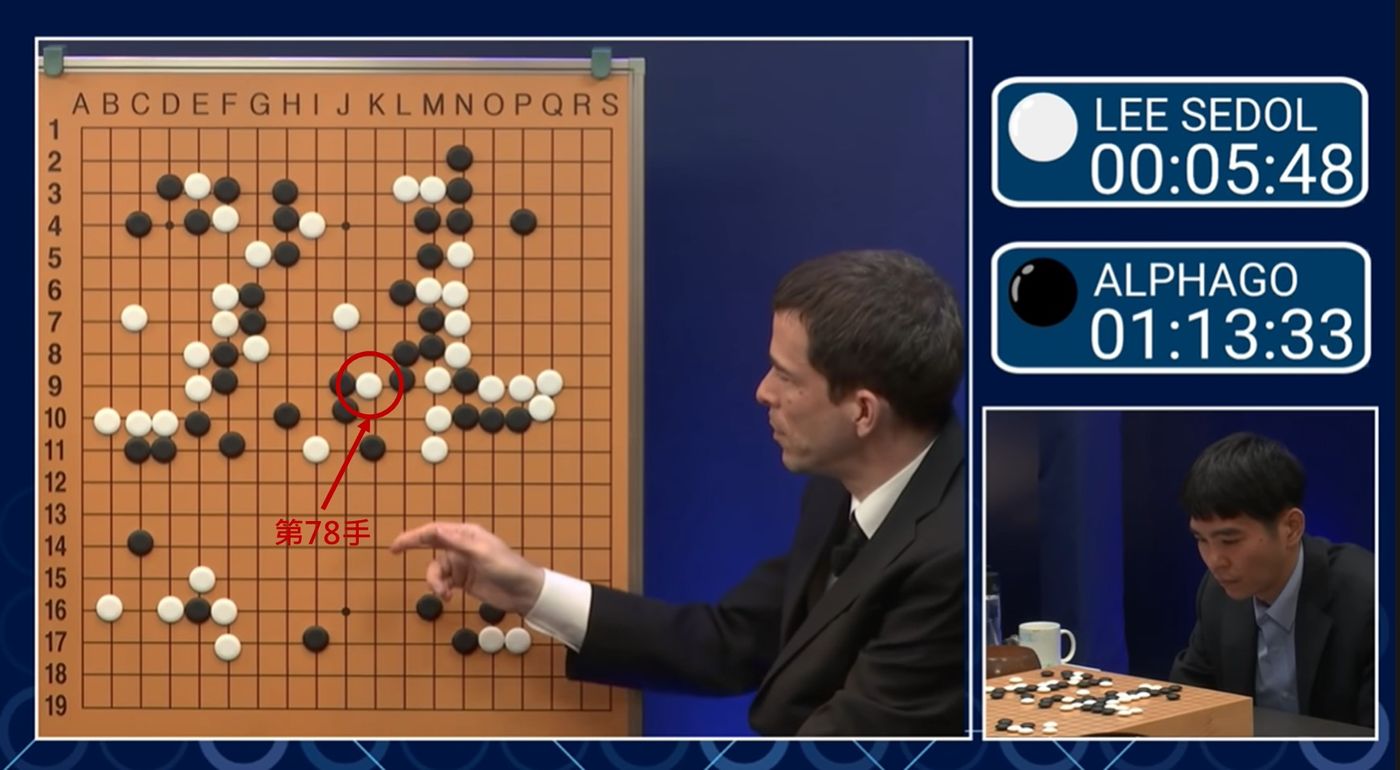

身为业余围棋爱好者,我永远无法忘记当初追直播时,看到李世乭投子认输的震撼。

书中提到的神奇37手,以围棋术语来说叫5路肩冲。传统认为4路是极限,但AlphaGo 却硬上5路。事实证明那是步好棋。

我更无法忘怀的,是看到李世乭在第四局使出浑身解数打出78 的鬼手,成功爆破中央,帮人类短暂守住最后堡垒时的感动。

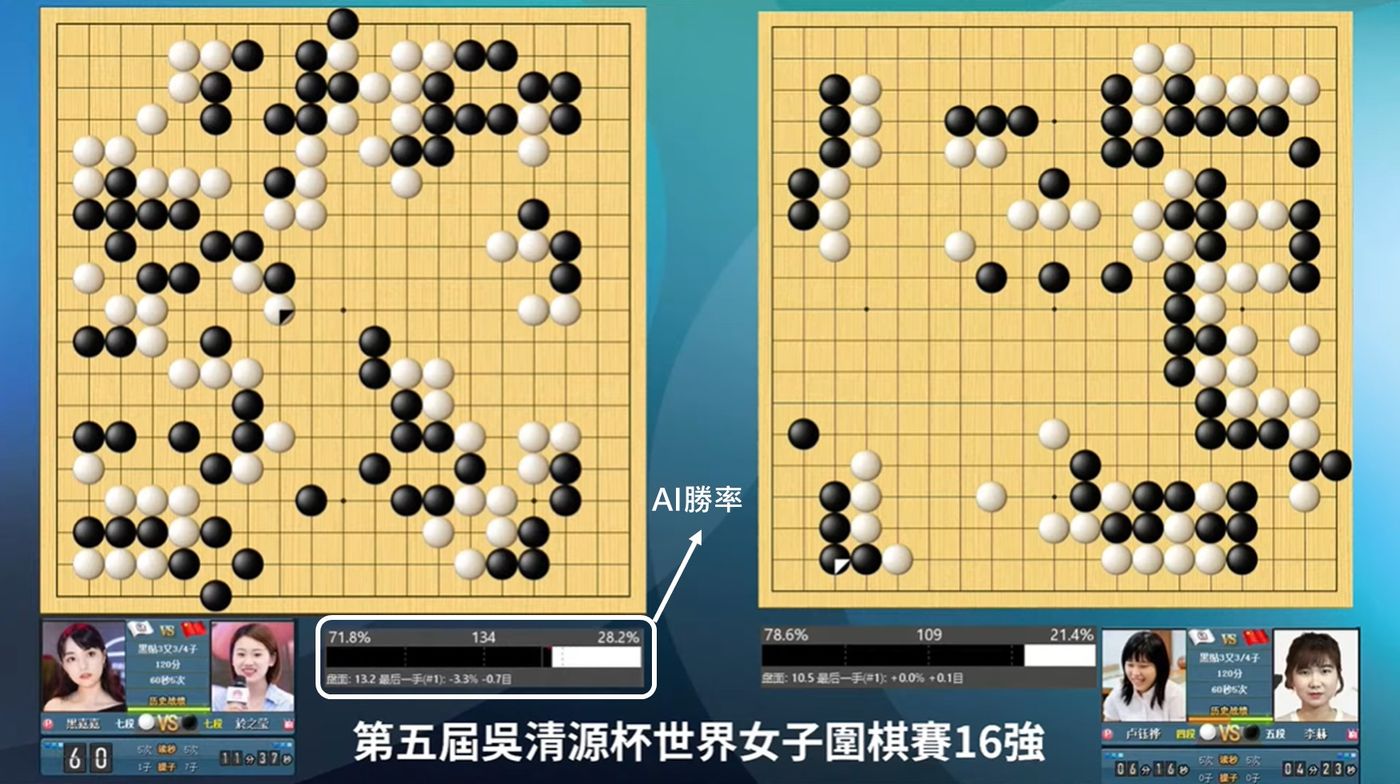

现在围棋使用AI辅助已非常普遍。棋手都会用AI训练,甚至直播时也会放上AI胜率图供观众参考。

对于现在不时有AI取代人类的说法,我觉得围棋的模式或可作为参考。如上头说的,现在棋手都会用AI训练,用电脑的推荐选点作为行棋参考。

但这并不意谓着AI取代人类。事实上,有些选点根本超越人类理解,就算照着下也无法掌握之后的变化。当今围棋第一人申真谞在专访中就提到,希望AI增加参考选点,让棋士能有更多选择。

或许这就是人类与AI能共荣的模式吧?藉由人工智慧协助,对人类遭遇的各种问题提供更多可能解方。而最终还是要靠人类自己选择,找到最适合我们的出路。

我想,不管面对隐私、误用等问题,最终还是要回归到「人」,思考这些应用是否能为人们,甚至是整个世界的其他生物带来更好的环境。纳入更多元的角度才不会走偏锋,而能利用AI 开拓出更崭新的道路吧!

你可能也会有兴趣的文章:

↓↓也欢迎大家来追踪〈姆斯的阅读空间〉的脸书和哀居↓↓

姆斯的阅读空间FB

姆斯的阅读空间IG

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐