為什麼樣本標準差要除以 n-1?

本文將以兩種方式來說明,第一種方法比較容易理解但也較不嚴謹,第二種則涉及較多數學運算,但可以彌補第一種的缺失,提供更明確的佐證。

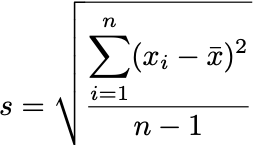

附上樣本標準差的公式:

從自由度的角度來看

什麼是「自由度 (degree of freedom)」?

自由度一詞在許多領域都有,這裡是指統計學上數據的自由度,意思是一個樣本中其數值能夠自由變動的數據個數。

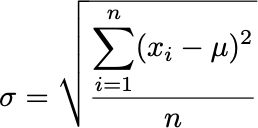

我們先看母體標準差的公式:

公式將所有數據和平均的差異加總(平方是為了確保其恆正,最後再開根號修正單位),並平均分配給 n 個數據。換個角度來看,每個數據偏移平均的量有大有小,標準差就是將數據偏離平均 μ 的程度平均分散給所有數據,因此達到呈現出「平均的數據差異程度」、「平均的差距」的效果。

當進行抽樣時,我們會期望樣本的行為和母體一樣,這樣這個樣本才有足夠的代表性,來作為母體的縮影。而在計算標準差前必須知道平均是多少才有辦法計算離均差,我們當然也不知道母體的平均 μ,所以估計樣本平均 x̄ 會和母體平均 μ 相差不多。就像我們做民調時,也是預期隨機抽出的部份人民的結果,會呈現出全體人民的意志(畢竟做普查的成本太高,只好參考抽樣結果)。

所以用 x̄ 來估計 μ,公式中原本 μ 的位置被 x̄ 取代。

可是明明抽樣是隨機的,如果 x̄ 要很神奇地等於 μ,其中必定有數據是不自由的。可以想像當我們抽了第 1, 2, 3, ..., n-1 個數據後,第 n 個數據必須要很神奇地是某個特定值,讓 x̄ 被強制修正成 μ,如此才會滿足我們原先對 x̄ 的期待。

現在要來計算標準差,一樣我們期望可以從樣本的標準差來推估母體,所以計算樣本的每個數據的離均差(這裡的「均」當然是指 x̄),進行平方加總後就可以得到總共的差距,然後要將這個總差距平均分散給所有數據......?

欸?可是並不是每個數據都能夠自由變動,獨立於其他數據,這樣還把誤差分給所有 n 個數據還合理嗎?因為我們是拿樣本來推估母體,可以將每個數據的離均差想成是它和平均 x̄ 之間的誤差,而又因為我們對 x̄ 的期望,其中至少要有 1 個數據為了要使 x̄ 等於 μ,它的值會由其他數據決定,那麼它和平均的差距當然也是,所以它的離均差其實是來自於其他 n-1 個數據,並不是這數據獨立造成。

簡言之,為了滿足原先對 x̄ 的期待,至少其中 1 個數據必須受限,才會做出正確的估計;或者反過來說,因為我們進行了估計,所以會期望至少有 1 個數據是受限的,統計學上用「自由度少了 1 」來描述這個概念。

因此計算樣本標準差 s 時就必須把總共的誤差只分配給 n-1 個數據,不只是不違背我們期望的數據行為,除以一個較小的數讓 s 稍微大一點,這樣估計也更加保守,而且也不用減 2 或減 3 等更大的數,減 1 已足夠。

不知道看到這裡是否有注意到,這樣計算出的結果本質上其實不是「樣本的標準差」,而只是一個我們給出的適合樣本的標準差公式,目的是為了做出適當的估計。這樣的估計方法在統計學上稱為「點估計 (point estimation)」,因為這只用單一數值來估計實際值,有別於像是信賴區間的「區間估計 (interval estimation)」,是用一段區間來進行估計。

樣本標準差 s 其實不是「樣本的標準差」,而是適合給樣本用來估計母體標準差 σ 的計算公式。

意識到了這件事之後,應該就能明白為何原本會對除以 n-1 這件事感到莫名其妙了,因為它根本不是在算樣本本身的標準差啊。

從不偏估計量的角度來看

看完上面的論述後,應該會有一點好像有道理但又不太確定的感覺吧?我們要怎麼比較嚴謹地確定這樣的估計是妥當的呢?

這就必須要介紹所謂的「不偏估計量 (unbiased estimator)」。如果一個用於點估計的統計量,它的所有可能值的平均會等於實際值,這樣的估計就是「不偏的 (unbiased)」,而這統計量就可以稱為不偏估計量。

「所有可能值的平均」?這個概念不就是期望值嗎?所以我前面才不斷使用「期望」這個字眼來敘述。

一般大家對期望值的印象應該是加權平均吧,而且如果當所有數據取到的機率相同,那期望值就是算術平均:

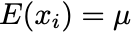

從母體中隨機抽出的第 i 個數據 xi,重複抽取很多次之後,這些抽出的值會很接近母體平均 μ,直到取到全部的可能值,取平均當然就是 μ,而其實這個 μ 正是我們對 xi 的期望:如果取夠多次的話它就會接近平均(畢竟實際上要取完母體的所有數據往往不切實際)。

如果一個統計量做的估計是合理的、不偏的,我們就可以期望如果重複進行這樣的抽樣估計,直到所有可能值都被取過後,這些值的平均就會等於我們的期望。

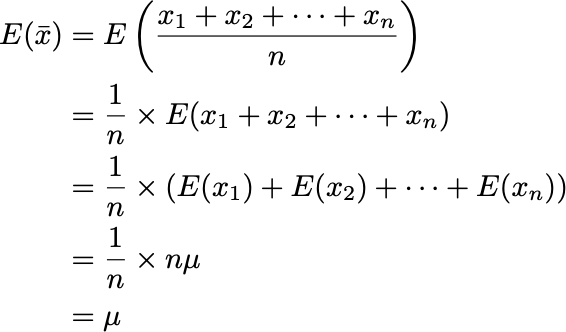

利用這樣的道理,以下先來算樣本平均 x̄ 的期望值,檢驗看看用 x̄ 來估計 μ 是否是妥當的,或者是說「不偏的」:

關於期望值的性質可以看文末的附錄,隨機變數相加的期望值可以拆開成各自的期望值相加。

由上面的推導可知,不只是單一數據 xi 的期望值會是 μ,一次取 n 個數據算出的平均 x̄ 的期望值也是,所以 x̄ 的確是 μ 的不偏估計量。

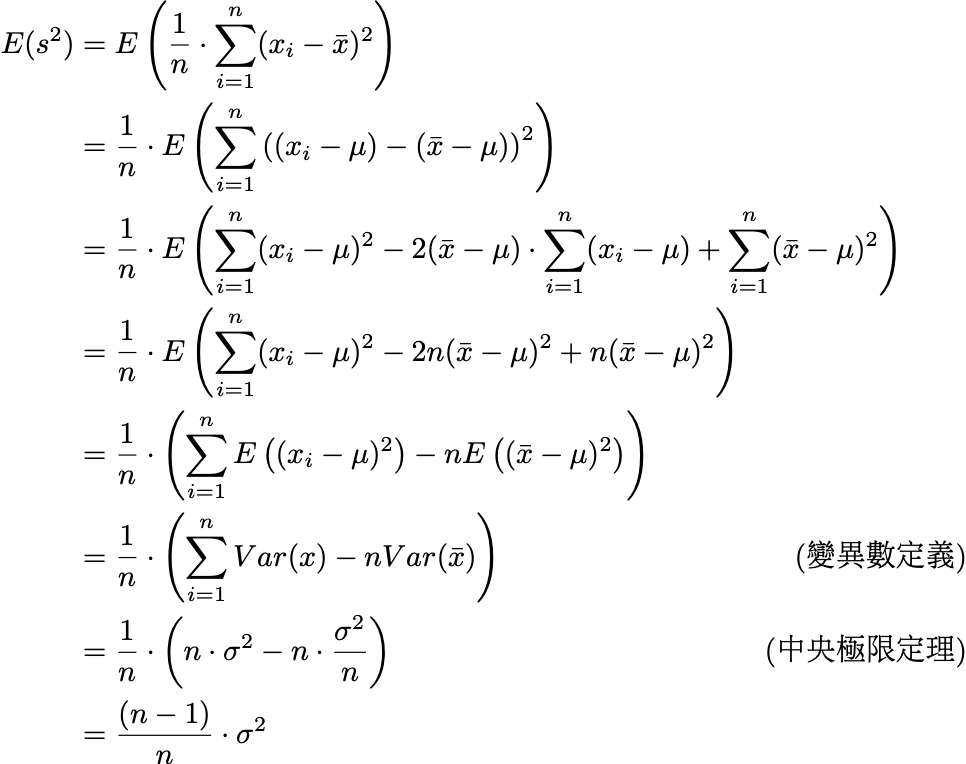

同樣道理,那麼樣本標準差 s 的期望值為何?我們一般會很直覺地認為應該和母體標準差公式一樣,也就是分母要除以 n,所以以下我將分母寫成 n,來看看會發生什麼事(為了計算方便改求變異數,連加的部分也寫成 Σ 節省版面,並請記得相加的期望值可以拆開):

稍微解釋一下倒數第四和第五行,期望值相當於算術平均,而離均差平方的平均正是變異數,所以才會等於 Var(x)。

從上面的推導可以發現,關鍵在於最後一步使用到的中央極限定理。最後面在計算樣本數據的變異數和樣本平均的變異數的差時,因為 x̄ 的變異數而造成提出 n-1 倍。如果一開始我們可以知道母體平均 μ 的話,就不會使用到 x̄,這裡就不會需要減掉 Var(x̄) 了不是嗎?

那麼為什麼 Var(x̄) 不是 0?因為 x̄ 就是抽樣得到的,他和 μ 肯定有差異,並透過中央極限定理得出變異數要除以 n 倍(標準差 σ/√n 的平方)。由此可見,因為我們已經利用 x̄ 來估計 μ,再繼續拿會使用到 x̄ 的標準差公式來估計 σ,自然就有了連帶影響。

如果一開始將分母除以 n-1,這樣的差異就被抵銷了,並得到 E(s²)=σ² 的結果,所以樣本標準差 s 的公式改成除以 n-1,才會是 σ 的不偏估計量。

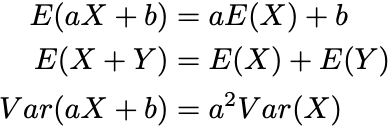

附錄:期望值與變異數的性質

因為不偏估計量的推導過程用到了一些性質,在這裡補充說明一下,對於任意隨機變數 X 和 Y,以及實數 a 和 b:

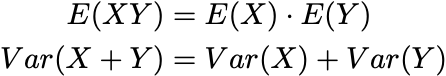

注意到第二條的 X 和 Y 兩隨機變數不需要互相獨立,所以在內文的推導過程中可以直接展開 E(x₁+x₂+...)。順帶一提,如果獨立的話還會滿足以下性質:

Var(XY) 則不能拆成各自的變異數相乘。對於這些性質的推導有興趣的讀者可以去翻閱數理統計或機率論相關的課本,或是網路上也已有許多證明可以參考。

- 如果喜歡我的文章,還請不吝【👏拍手】、【➕追蹤】!

- 我平常更常在 instagram 發布短文,等內容累積到一定的量後才會整理出完整文章發布在這,也歡迎有興趣的讀者來逛:@study.msh