斯坦福大学复制出ChatGPT人工智能 训练成本低到令人发指

不久之前,只有研究人员和学者在密切关注大型语言模型的发展。 然而,去年年底,ChatGPT的发布让世界震惊:现在机器能够以一种几乎与人类无异的方式进行交流。 它们能够在短短几秒钟内撰写出文本,甚至是在各种复杂领域中创作高质量的编程代码。 正如GPT-4的发布所示,它们正在以惊人的速度不断进步,这将像其他技术一样从根本上改变人类社会,因为它们有可能自动化一系列工作任务,尤其是在白领劳动力中,这在以前被认为是不可能的。

与ChatGPT表现惊人的Alpaca人工智能在许多任务上表现相似,但它建立一个在一个开源的语言模型上,训练成本不到600美元。 这表明这些神一样的人工智能已经变得非常便宜且容易复制。

除了斯坦福大学的Alpaca和ChatGPT,许多其他公司,尤其是Google、苹果、Meta、百度和亚马逊等,也在追赶这一潮流,并将人工智能应用到各种应用和设备中。 如果你是Bing的用户,你已经可以在搜索引擎中使用语言模型了,而它们很快也将在其他场合出现。 它们将融入你的车、手机、电视和电话中,甚至也将出现在机器人中。 但值得一提的是,OpenAI和其他大公司都认识到这些机器在垃圾邮件、错误信息、恶意软件、针对性骚扰以及其他让人感到担忧的使用场景中有着极大的潜在危险。 因此,在发布产品之前,他们手动调整了这些功能,并且OpenAI的CEO萨姆-奥特曼(Sam Altman)也是那些担心政府行动不够迅速的人之一,他认为应该为人工智能设立一些公共利益的保障措施。 然而,你现在可以花费600美元自己构建一个语言模型。 一支研究小组在斯坦福大学已经实现了这一目标,他们的惊人表现凸显了整个行业和其可怕的能力可能迅速失控的风险。

该研究小组以Meta的开源LLaMA7B语言模型为基础,这是目前几个LLaMA模型中最小和最便宜的模型之一。 虽然它在一万亿个“tokens”上进行了预训练,但这个小语言模型在大多数任务上明显落后于ChatGPT。 GPT模型的主要成本,甚至主要竞争优势,来自于OpenAI在后期训练中的大量时间和人力投入。 读了十亿本书是一回事,但通过大量的问答式对话来教导这些AI的实际工作是另一回事。

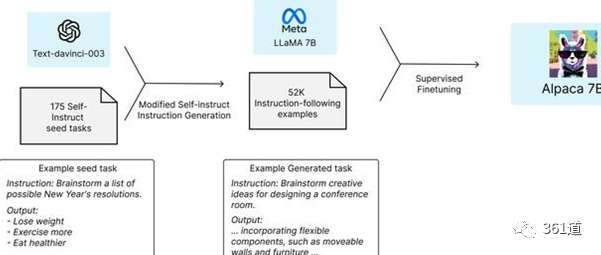

因此,斯坦福大学的研究小组基本上要求GPT采用了175个由人类编写的指令/输出对,并开始以同样的风格和格式生成更多的指令/输出对,每次20个。 通过OpenAI提供的一个有用的API,这个过程自动完成。 在短时间内,该团队就获得了大约52000个对话样本,用于后期训练LLaMA模型。 生成这些大量训练数据的成本不到500美元。

接下来,他们用这些数据微调了LLaMA模型,这个过程在8台80GB的A100云处理计算机上花费了大约3个小时,花费不到100美元。

最近,斯坦福大学的一个团队利用GPT-3.5,向LLaMA7B提供了一套操作指南,帮助其完成任务。 该团队还对他们的模型进行了测试,称之为“Alpaca”,并将其与ChatGPT进行了比较。 在电子邮件写作、社交媒体和生产力工具等各个领域的测试中,Alpaca获得了90项胜利,GPT则赢得了89项。

这个团队感到惊讶的是,尽管模型规模较小,指令也不是特别多,但Alpaca在测试中的表现还是很出色的。 此外,他们还对Alpaca进行了交互式测试,发现在不同的输入集上,Alpaca的表现往往与text-davinci-003[GPT-3.5]类似。 当然,他们也承认,他们的评估在规模和多样性方面存在一定限制。

该团队表示,如果他们希望进一步优化这个过程,他们可能可以更便宜地完成任务。 此外,现在有更强大的GPT4.0和LLaMA模型可供选择,因此任何人都可以获得这些更强大的工具,并进行更广泛的研究和实验。

斯坦福大学的团队已经在Github上发布了他们使用的52000个问题,以及生成更多问题的代码,还有他们用来微调LLaMA模型的代码。 但该团队也强调指出,他们还没有对模型进行微调以确保其安全无害,因此希望任何使用该模型的人都能报告发现的安全和道德问题。

然而,有没有什么阻止任何人花费100美元左右创建他们自己的人工智能,并按照自己的选择进行训练? OpenAI的服务条款禁止使用其输出来开发与OpenAI竞争的模型。 而Meta表示,在当前阶段,只有学术研究人员可以在非商业许可下使用LLaMA。 但整个LLaMA模型在公布一周后就在4chan上泄露了,这引起了一些争议。

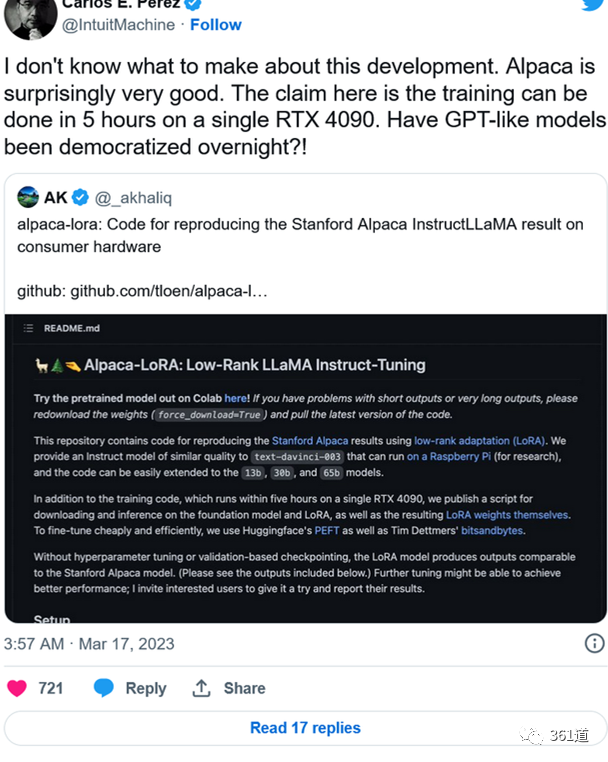

此外,还有一小组人称他们已经设法降低云计算成本,并在Github上发布了更多的代码,可以在树莓派上运行,并在单个高端nVidiaRTX4090显卡上在5小时内完成训练过程

这一次的实验让我们看到了令人惊讶的事情:现在人们可以以相对低廉的价格建立自己的语言模型,而这些模型可以是未受控制的,由那些具有机器学习知识、不在乎法律条款或软件盗版的人所建立。 这也意味着,那些致力于开发自己语言模型的商业人工智能公司可能会受到一定冲击,因为大部分时间和费用都发生在训练后阶段,而这项工作可以在较短的时间内完成。 对于其他人而言,这个软件的功能可能会被用于不好的用途,例如专制政权、网络钓鱼行动、垃圾邮件发送者或其他可疑人物。 这个精灵已经被释放出来,并且似乎很容易被复制和重新训练。