變臉App背後的技術Deepfake到底是什麼?他所潛藏的危機你知道嗎

你也許玩過換臉 App(例如FaceApp、ZAO),試過將自己的臉換到明星身上。這麼有趣又厲害的技術其實被稱作Deepfake,但他到底有什麼爭議?

Deepfake夯什麼?

Deepfake名人色情片

早在2017年國外就有Reddit用戶 Deepfakes 創立子論壇「deepfakes」(現在已經不存在),張貼利用 AI 技術偽造的好萊塢女星色情片。

而從去年2020年開始,台灣有大量網紅合成性愛影片開始在網上流傳。並且在2021年 YouTube 用戶“小玉”被發現是負責銷售、委託和傳播這些女性“深度偽造”色情影片,其中被用來放置在色情影片中的受害者包含理科太太、白癡公主、球球、奎丁、黃捷、高嘉瑜等6名知名公眾人物,Deepfake(深度偽造)問題在台灣引起了廣泛討論。

Deepfake詐騙

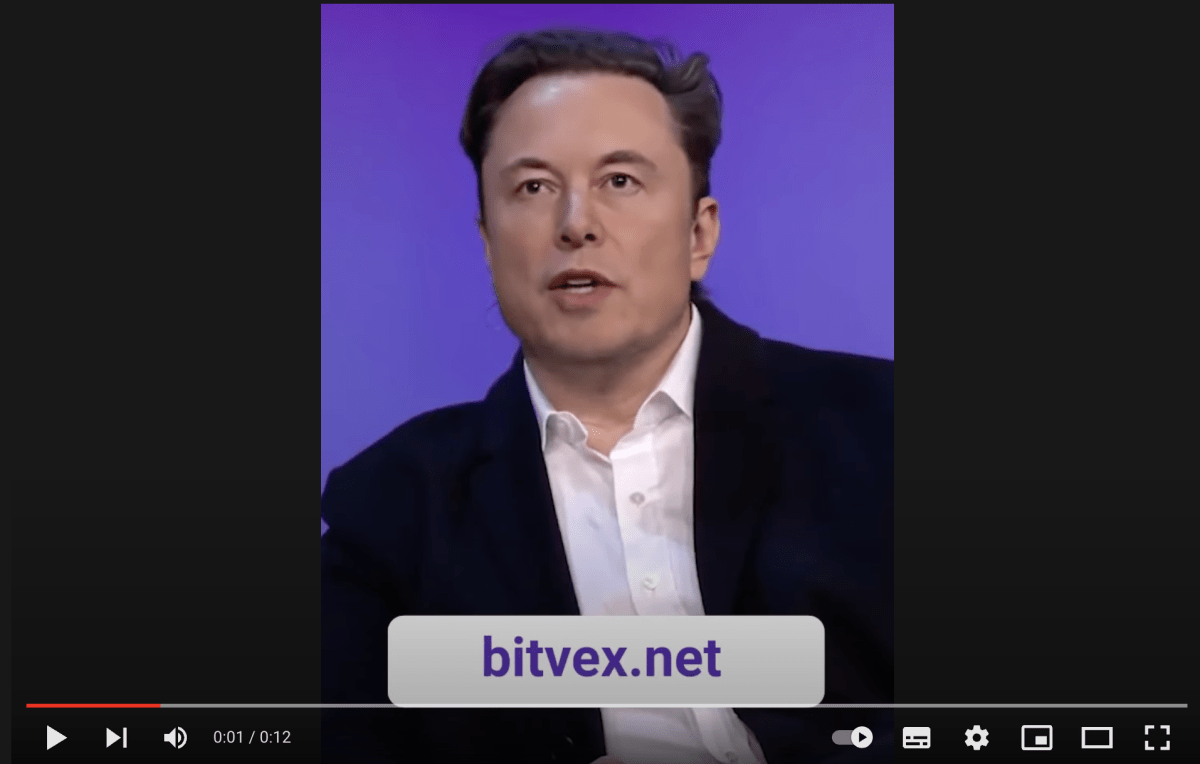

就在這幾日,網友發現YouTube上出現大量科技業以及投資界名人的短影片,每一則都在宣傳BitVex這個詐騙加密貨幣交易平台

事實上,這就是用Deepfake技術做的,讓影片中的人能夠以馬斯克的臉和聲音說話、拍影片,但其實這根本不是馬斯克本人拍的

請參閱:Deepfake詐騙!馬斯克和幣安執行長都遭冒用推銷詐騙加密貨幣交易平台BitVex

什麼是Deepfake?

深偽(Deepfake)一詞於2017年問世,是深度學習(Deep Learning)與偽造(Fake)混合而成的單字。

Deepfake是在現有的圖片或影片上添加與聲音或外貌相似的人工智慧制作的媒體內容。人工智慧可以有效地從不同角度了解目標的臉是什么樣子的,以便將臉轉換到原始的演員上,他就像是一個面具。Deepfake通常被稱為合成媒體的一種形式,它能夠準確地模仿人的臉、動作和聲音,以至于人們往往无法區分真假。

以麻瓜的語言來說:把A的臉/聲音換成B的臉/聲音。甚至可以讓影像中的B說出或做出他從來沒有做過的事情。

或是可以看看以下這則影片,小玉本人親自示範Deepfake要大家小心別讓這項技術被有心人利用,是不是很諷刺:

Deepfake的應用

基於網路上已經有許多開源的程式碼,製作Deepfake影片不需工程或資訊相關背景,只要顯示卡和 CPU 等電腦硬體設備夠好,花一點時間訓練,就有能力製作。因此無論是在怎樣的用途上,這是一個成本不高但成效很好的技術。

Deepfake正面用途

Deepfake因為這次的負面事件引發大家關注,然而這項技術本身在某些程度上原本是很好用的發明。

在遊戲中,Deepfake可以用來做出非常擬真的人物肖像。甚至可以被用於那些幫助我們線上試穿衣服或髮型的App。

而在影視行業中,甚至可以用來做影片的修復和配音看起來更加無違和感,甚至可以讓演員在未到場的情況下,將臉放置在替身身上。

網路上也有一些帳號專門在做電影翻拍後的主角對比,例如將1970年代的神力女超人女主角Lynda Carter放到2017年的神力女超人Gal Gadot身上

Deepfake爭議

Deepfake爭議一、變臉色情片

這也是這一次小玉爭議中最主要的討論點,國內外有許多不肖人士將知名人士的臉移花接木到色情片女/男優身上之中,雖然也有男性受害者,但主要還是以女性居多,也造成一種新型態的數位性暴力。

而這樣的變臉色情片在傷害人的同時,也創造一筆很可觀的不法收入,根據鏡週刊的研究發現2020年10月起,名為「台灣網紅挖面」的帳號在推特上提供眾多「AI 換臉」色情試看片。製作方提供約 30 秒「試看片」作為宣傳,若要看完整版本,則須付費成為Telegram聊天群組會員,站方還會不定期提供各種「加值服務」。

在農曆過年前,群主甚至發出「過年回饋」廣告,推出「雞排妹大禮包買一送三」

甚至有時可以「接單客製」,接受付費指定製作「素人換臉色情片」,或讓會員「集資競標」,競標單價甚至能達單筆萬元以上。

而這樣的Deepfake變臉色情片一方面可能被利用作為報復前任的工具,甚至可能毀掉一個人的名譽,你想想,有許多受害者稱不知道自己該不該澄清,澄清了一方面擔心助長影片的散播,另一方面他們不知道該怎麼和大家說『那並不是我!』甚至走在路上當被別人交頭接耳盯著看,還會懷疑是不是他們曾經看過那則影片。

Deepfake爭議二、Vishing釣魚/詐騙

Deepfake除了可以做成影片,也能夠使你希望仿造的對象說出你希望他說的話,而這項技術就常常被用在仿冒公司高層的聲音上。以此騙取底下員工的信任,進而給出公司重要資料或是金錢。

在2019年3月,曾經有報導顯示英國一家能源企業的CEO以為是在和德國總公司CEO通電話,因為老板要求他把資金轉交給匈牙利的供應商,對方要求很緊急,並要這名英國CEO在一個小時內付款,並稱會在事後償還。然而英國CEO把錢轉出去後,對方立刻就把錢轉走,而且沒有償還,甚至企圖再騙第二第三次。

Deepfake爭議三、假訊息

現在有了這項技術,有影片/有圖已經不代表真相,製片方可以讓任何人說出或是做出他從來沒做過的事,而當這樣的影片流出又有多少人能夠分辨得出他是假的呢?

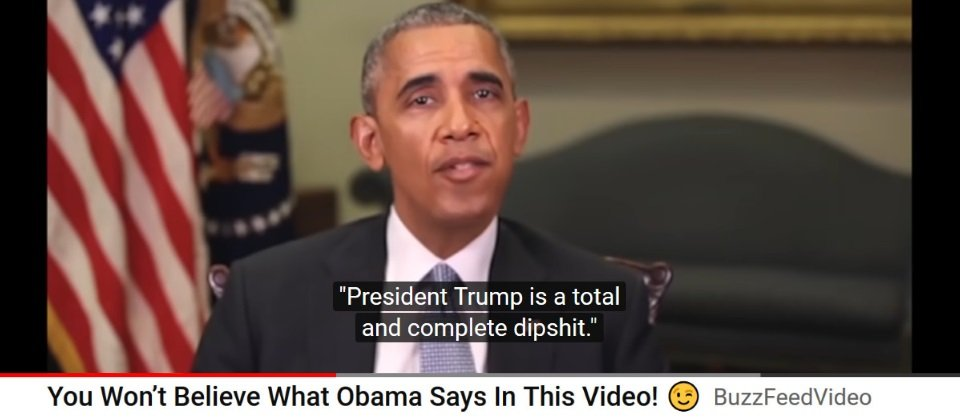

在2018年時國外網路媒體Buzzfeed曾經製作AI假影片,呼籲大眾要謹慎判斷網路上的消息。他們發布了一則Deepfake的歐巴馬演講影片,以AI技術來改變前美國總統歐巴馬的致詞內容,他們在原始影片中默默將一句話改成「川普總統完全就是個笨蛋!」。但事實上歐巴馬從來沒有說過這樣的話。

這樣Deepfake的利用一樣會造成一個人的名譽受損,甚至有可能危害國家安全。

Deepfake爭議四、身份盜用

因為網路銀行的興起,已經有越來越多的銀行可以接受視訊電話開戶,然而這就又是Deepfake可能用來操作的地方,他只要有一個人的多張照片(現在大家的照片都很好找,社群媒體上一翻百百張),就可以使用對方的臉做視訊電話,盜用對方的身份開戶。

小心哪天就被警察找上門,你還不知道為什麼…

如何辨識Deepfake

- 不自然的演講節奏

- 機器人腔調

- 不自然的眨眼或動作

- 嘴唇的動作和說話不同步

- 音頻或視頻質量差

- 燈光或膚色突然的變化

發現自己或親友成了受害者怎麼辦

- 截圖存證(文字、對話、日期時間、連結、影像等)

- 立刻報警尋求警方協助

- 求助 iWIN (網路內容防護機構)協助移除影像

- 不要轉傳,也不要持有

這種技術不如我們平常所說的不要亂點連結、隨便付款就可以預防自己受害,這樣的技術需要擁有一個人大量的面部或是聲音資料,你可以做的就是好好保護你的個資,在社群上發布照片影片時三思,盡量不要過度分享私人訊息外,也可以把隱私設為非公開以免不肖人士利用!

全方位防詐騙工具包:

- 學習更多防詐小撇步:防詐達人部落格

- 了解防詐達人:防詐達人官方網站

- 一秒辨識詐騙網站:防詐達人聊天機器人

- 和大家一起討論詐騙:防詐達人-全民反詐騙通報中心