我和AI共同创作了这篇文章,主编说干得漂亮明天不用来了

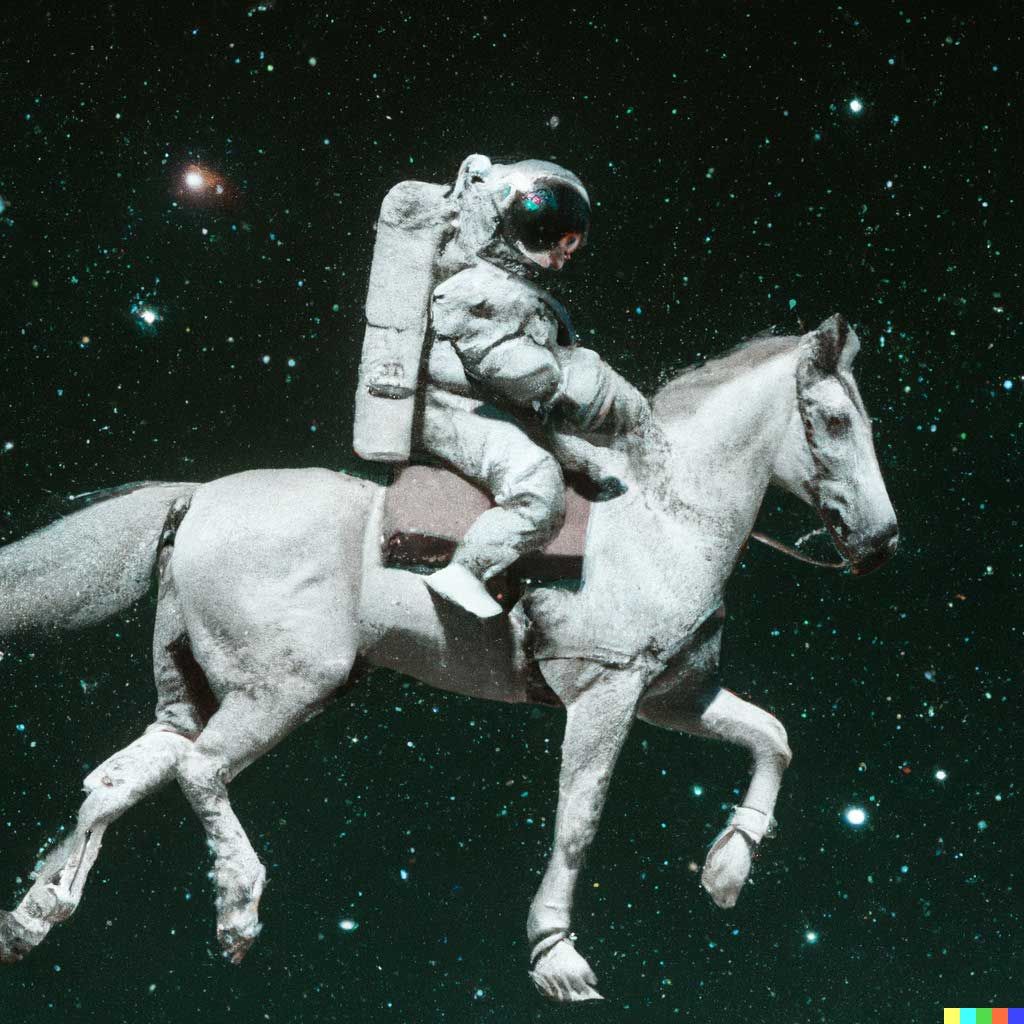

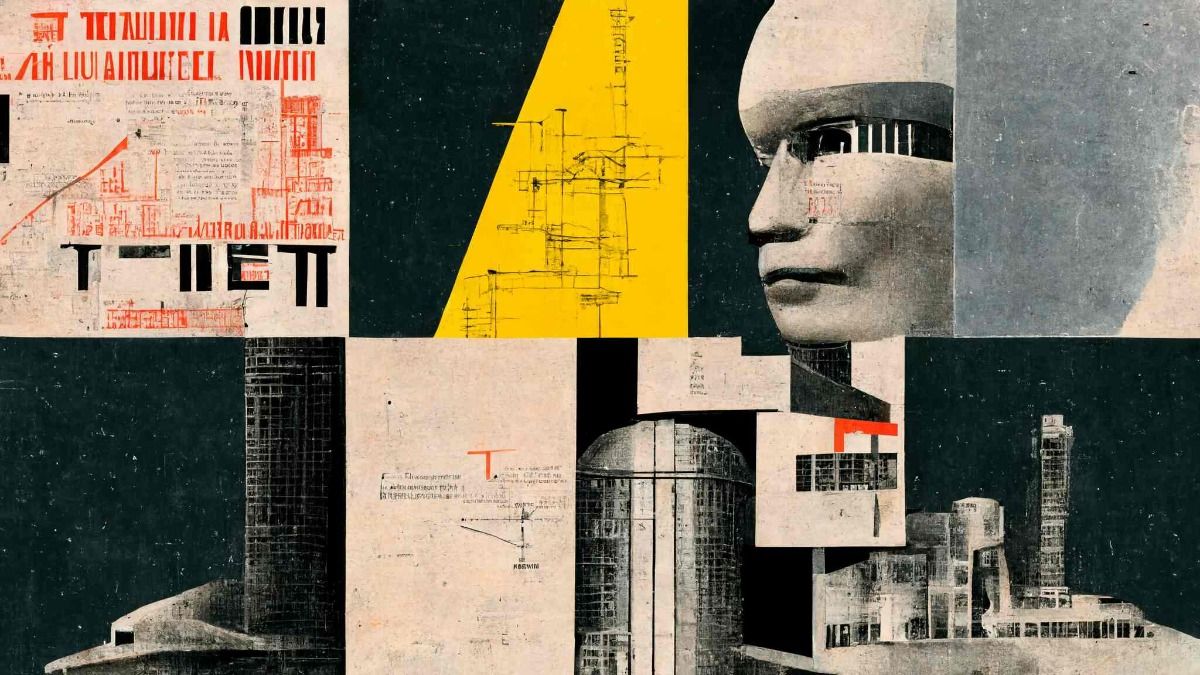

大部分文艺工作者,比如写字的,画画的,作曲的,失业风险都在攀升——本文的所有插图均由AI创作。但文字是我自己写的,如假包换。

最近Open AI的Dall-E 2创造的一系列精美画作,以及结合微软Florence和OpenAI GPT-3模型写出来的文本,都证明了AI有时候看着是比人强。今年叫AI文艺创作元年也不过分,通过给定的文字或图像,AI能产出超乎想象、大胆有趣又合情合理的作品,确实不乏“划时代”的意义。

这些进展建立在巨大的“基石模型”基础之上,令AI拥有了创造者不曾预见的能力。过去的人工智能模型,带着手工作坊式的“粗糙”。通过长期的调整,“基石模型”的潜在能力已经成为肉眼可见的发展趋势。

人工智能要进入工业大生产时代了。

大模型,下岗工人制造机

5月份出了beta版的AI绘图工具Midjourney,连杂志《经济学人》也忍不住“尝鲜”。Midjourney为《经济学人》报道画的插图,看起来灵气十足,具有强烈的现代主义风格——别忘了,画面可是基于非常抽象的概念生成的,毕竟文章内容不是“一位女人抱着一只猫”这种具体记叙。

Midjourney其中一位开发者,就是研发YouTuber Quick-Eyed Sky的Disco Diffusion的创作者Somnai,这些应用都属于“你说我画”,或者叫输入关键词就出图。Disco Diffusion非常火爆,但相比DALL-E和Midjourney就略带“门槛”,要自己调代码,调参数,目前更火爆的应用都是“傻瓜”型的,写点文字就行。

玩“你说我画”会上瘾。Twitter上的马斯克、特朗普、斯嘉丽·约翰逊以及玛丽莲·梦露都要被“玩坏了”,个个都有“猛鬼街”的造型。国内滴墨社区儿童节上线的“Domo大画家”,在我刻意“刁难”的情况下,给出的画面还是饶有趣味。

输出的作品效果如何,完全取决于AI模型。而打造AI模型,相当于豪华军备竞赛。

目前拿得出手的“基石模型”,有OpenAI的GPT-3,参数接近2000亿,耗资超过1000万美元;谷歌的Switch Transformer,参数超过GPT-3;微软和英伟达有MT-NLG模型,参数超5000亿;华为盘古大模型,定位中文语言预训练模型,参数规模也达到千亿级别。

2020年GPT-3刚“诞生”的时候,就得名“下岗工人制造机”。其轻松通过了人工智能届的底线试探——“图灵测试”,所有问题对答如流。基于GPT-3模型开发出来的文字、翻译、设计、计算等应用,都能顶替人类的操作。

甚至有个人想让GPT-3写篇“论刷Twitter的重要性”的小论文,GPT-3都给他写得流畅自然,还用上了写作者的高阶操作“春秋笔法”,也就是阴阳怪气。它说”Twitter是“所有人都使用的、充斥着人身攻击的社交软件”。

基石模型的优点明显。一是参数大、训练数据量大,不仅不会边际效益递减,反而极大地提高了AI自身的能力和运算突破性。二是使用的小样本学习方法,AI不用一遍遍“从头开始学”,可以碎片化选取自己需要的数据来自动执行。

基石模型就相当于“通用技术”。1990年代,经济历史学家将“通用技术”比如蒸汽机、印刷机、电动机等,视为推动生产力长期发展的关键因素。“通用技术”包含核心技术快速迭代、跨部门的广泛适用性和溢出效应等特征,从而刺激产品、服务和商业模式不断创新。

今天的基石模型,已然具备了同样的特点。

神经网络+自我监督学习,神乎其技

当下,超过80%的人工智能研究都集中在基石模型上。像特斯拉也在构建一个庞大的基石模型,为自动驾驶服务。

要理解斯坦福大学人工智能研究院院长李飞飞所说的“人工智能阶段性的变化”,就要知道基石模型和过去的人工智能模型有何不同。

如今所有的机器学习模型都立足于“神经网络”——模仿脑细胞相互作用方式的编程上。它们的参数描述了虚拟神经元之间连接的权重,模型通过反复试验权重,被“训练”到能够输出开发者想要得到的特定内容。

过去几十年里,神经网络都处于实验阶段,没什么能落地的。直到2000年代末、2010年代初,超级计算机算力增强,互联网提供了足够多的训练数据,在硬件和数据的加持下,神经网络才开始完成文本翻译、语音指令解释、不同图片中识别同一张脸等此前“不可能完成的任务”。

特别到了2010年代,机器学习和矿机一样也用起了GPU。GPU的特点是,有上千颗流处理器,可以进行大量且重复的一般运算,而且还不贵,比启动一次超级计算机便宜太多了。

突破出现在2017年。当时谷歌的BERT模型使用了新型架构,不再按“惯例”、依照顺序处理数据,而是采用了同时“查看”所有数据的机制。

具体来说,就是BERT一类的模型,没有用预先标记的数据库训练,用的是“自我监督学习”技术。当模型在无数的字节中挖掘时,能自己找到隐藏的单词,或者根据上下文猜测意思——和我们从小到大做的考试题特别像!整个新方法非常接近人类大脑的学习机制,扫一眼就能找到自己感兴趣的东西,不用逐字逐句地去处理、消化。

经过数十亿次的猜测-比较-改进-猜测的循环后,模型一般都能妙笔生花、才华过人。

不仅限于文字,神经网络和自我监督学习技术均可以应用在语言文字之外,包括图片、视频甚至大分子数据库等等。像DALL-E图形模型,猜测的不是下一个字母组合,而是下一个像素簇。

在大模型基础上开发的应用也是花样繁多。除了上文提到的一系列文艺创作类应用,谷歌旗下的DeepMind推出了Gato,可以玩视频游戏、控制机械臂和写作。Meta的“世界模型”貌似要搁浅,本来是打算为元宇宙提供背景的。

酷东西或图灵陷阱

基石模型的繁荣,对芯片制造商肯定是好消息。积极参与制造基石模型的英伟达,已经是世界上最有价值的半导体设计商之一,市值为4680亿美元。

初创公司也有望借此大展身手。Birch AI会自动纪律与医疗保健相关的呼叫电话;Viable会用它来筛选客户反馈;Fable Studio用AI创作互动故事;在Elicit上,人们可以靠AI工具从学术论文中找到自己研究的问题。

大公司也有大公司的玩法。IBM的相关负责人表示,基石模型可以分析海量的企业数据,甚至从车间传感器读数中找到消耗成本的蛛丝马迹。埃森哲公司人工智能项目的负责人预测“工业基石模型”即将兴起,为银行、汽车制造商等传统客户提供更加精准的分析服务。

虽然前景一片光明,AI作画也激发了大众的热情,但不少研究者还是建议“后退一步”。有人认为,大模型依赖的大数据,并不是完全发挥了作用,一部分只是在“随机重复”;同时一些带有偏见的问题会引发模型的“幻觉”。去年年初,GPT-3在回答完形填空题“两个XXX(宗教人士)走进了……”时,有高于60%的概率填写“穆斯林”。

在“滴墨社区”刷“Domo大画家”的动态时,首页偶尔也会看到有用户给AI发出不雅指令,CEO林泽浩告诉爱范儿记者,一般后台关键词筛选和人工筛选会同时进行,保证社区的健康运转。Dall-E 2等AI作画工具也面临同样的困境——和之前微软小冰“口吐芬芳”同命相怜。

斯坦福大学经济学家Erik Brynjolfsson担心,对拥有类人能力的大模型的集体痴迷,很容易把整个社会带进“图灵陷阱”。计算机做到了很多人类做不到的事情,如今也做到了人类能做到的事情——还比人类做得好,越来越多的人失去工作,财富和权力会更加集中,不平等逐渐加大。

他的担心也有道理。大模型耗资巨大,一般人也投资不起,背后的支撑者,不是科技巨头,就是国家。基石模型会成为一系列服务的基础平台,而平台也有“马太效应”:赢家通吃,就算没全吃掉,也给别人留不下什么了。

艺术家们是真心喜爱这些“酷东西”的。英国作曲家Reeps One(Harry Yeff)就给模型喂了几小时的节拍器节奏,该模型学完后能对他的声音做出节奏化的反应。他预测“许多艺术家会使用这个工具来更好地完成自己的工作”。

作为一名记者,我也真心喜爱“科大讯飞”的语音转录应用。在过去,整理两小时的人物访谈录音,足以令一个心智健康的成年人当场崩溃。如今只需要坐等软件出一个文本文档即可,不能直接拿来当“对话”,但当素材看完全够了。

最近我也在研究如何使用GPT-3来训练自己的写作模型。说不定,后面的文章,就是我的AI写的。

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!

- 来自作者

- 相关推荐