《只需你三秒的聲音,新的 AI 語音合成技術即可學習並重建 “你”》|存在指南 Way To Exist

對於身處於臺灣的一般民眾來說,2023 年可謂我們公眾實際泛用 AI 人工智慧、深度學習生成、巨型語言資料庫的第一年,一般人不再只能看著學術論文、聽著學者們紙上談兵。這一切在 ChatGPT 正式開放使用後揭開帷幕,我們理解並見識到了使用一個已經學習好且可以理解普通對話的大型資料庫是多麽的方便,在興奮與恐懼交織的同時,也讓更多憑藉 AI 、大型模型或預訓練生成技術的相關專案浮上檯面,而今天要簡介的,並非已投身市場的文字轉圖像工具,而是潛伏於眾人目光之下更久的「文字轉語音合成技術」—

只需要你三秒的聲音,新的語音合成技術即可學習並重建 “你”

大綱 Outline

- 語音合成發展 - Concatenative 到 Generative

Text To Speech Synthesis - TTSS

方式相較簡單、最先被大眾使用的 Concatenative Synthesis

Parametric / Deep Learning Text To Speech Synthesis

Gooogle 的語音發聲到 Apple 結合資料庫的生成式語音 Siri - 簡介 VALL-E / AudioLM

結合 GPT-3 - 音樂製作、創意產業的震撼彈 MusicLM

- 簡介 TTSS 技術層面

類比訊號與數位訊號 - 人類與電腦、連續與離散(Continuous & Discrete)

新的語音產生方式

數位化與 Token

OPEN-AI 的 Whisper

語音合成發展 - Concatenative 到 Generative

Text To Speech Synthesis - TTSS

在人類科技研發,技術革新時,可以感受得到一個隱約的共同目標:

科學家們試圖讓人類不再孤寂、讓科技始於人性,甚至無異於人性。

歷經計算機(電腦)的發明後,這一切有了大進展,例如原本因戰爭用途而打造的大型 Vocoder 能夠即時的轉換原本的人聲、音高,並進一步地重組聲音,讓原本的聲音無法辨識。

最早開始致力於開發 Vocoder 的人是在 1928 年時 Bell Labs 的工程師 Homer Dudley。 二次世界大戰期間,美國政府投資了一個演講編碼技術。Dudley 所做出的 Vocoder 被用在 SIGSALY (二次大戰期間用來編碼高等機密對話)系統裡。

千禧年後,改變聲音、模擬人聲的遠景再次被放大,諸多電腦、科技廠商開始致力於研發能夠 “說話” 的機器,畢竟前面說到我們想讓科技與人性平起平坐,而在機器能夠自己思考前,讓其開口發聲似乎也是一個「人類化」里程碑。

於是 TTS 的研究方向就此誕生:

我們打出一段字,電腦可以說出這段字,又或者是,電腦可以自己說出其所顯示的文字,即 Text To Speech Synthesis ,文字轉語音。

方式相較簡單、最先被大眾使用的 Concatenative Synthesis

最初,這樣的構想被佐以一個相較簡單的實現方式:錄製好一個人類說話的聲音,且包含一個語言中所需要的音節、音素(Phoneme),接著將這些資料數位量化後存儲進入一個資料庫中,而當電腦需要「說話」時,則從其中提取元素(聲音波形),依據所需聲音結合後,再轉換為類比訊號經由喇叭播送出來,此即是湊合式(串連、拼湊式)語音合成的基本概念。

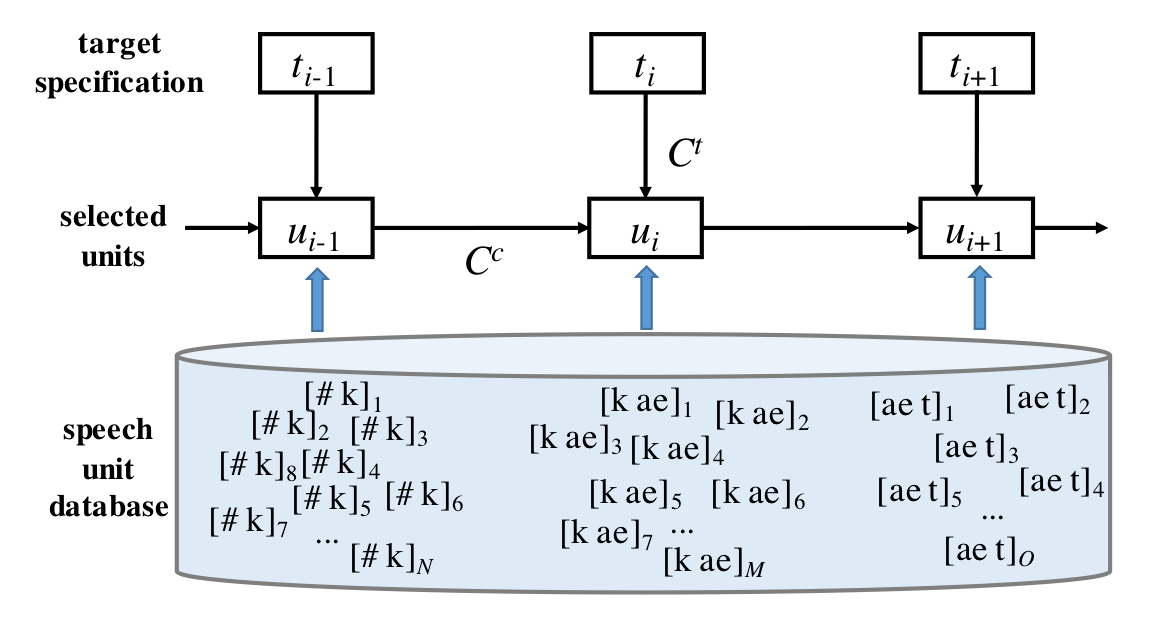

當目標 t 被提示(Prompt, 提及)時,系統辨識並從資料庫中提取出最相關的值 u ,透過連續進行這樣的動作來達到連續的、協調的(Coherent)意義語句。

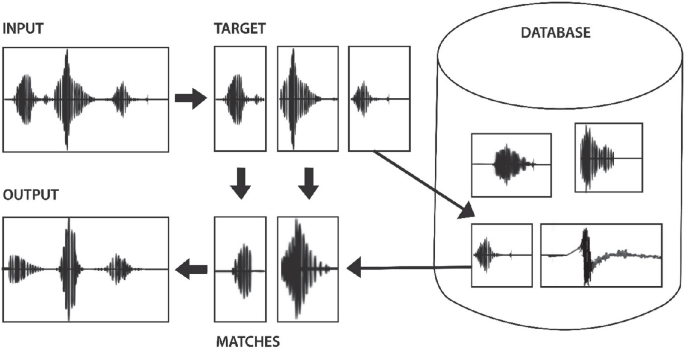

透過更為簡單的波形示意圖,我們可以看到從資料庫中提取相似波形並拼湊起來輸出的過程。

補充概念 - 前文中提到的 “音素 Phoneme” 概念如下: 在最小單位的形容下, 基因(Gene)可以表示構成生命藍圖的最小單位; 迷因(Meme)可以表示構成文化的最基本單位; 音素(Phoneme)則表示各語言中構成有意義的聲音的最小單位, 例如:啊...在中文意義系統中可能代表驚訝、被震驚或錯愕的概念,則 “啊 uh!” 則為一個 Phoneme 。

此語音合成方式的優勢有,較為簡易的系統運算需求,快速合成人類可以聽得懂的聲音。缺點是,必須花費龐大的時間及人力預先錄製人聲,並有足夠的資料儲存空間,且在長語句、艱澀發音的字詞上很容易卡頓、語音模糊不自然等等,也無從改變聲音的語氣、音調與情緒。

Parametric / Deep Learning 參數式、結合深度學習後的語音合成

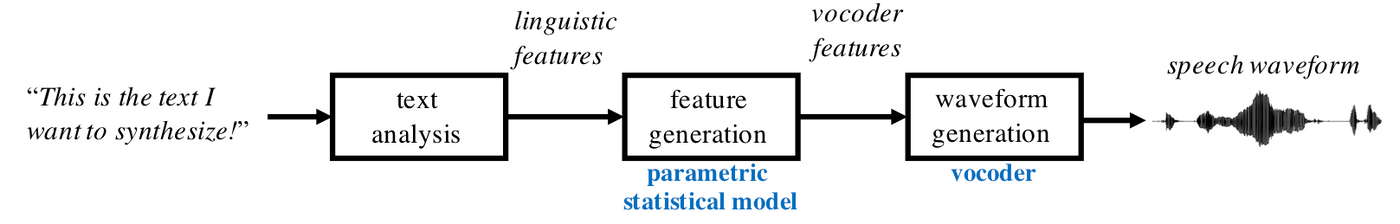

程式從輸入者所給的 Prompt 中辨識音素(更準確的說法是辨識聲音特徵,在欲產生人類語言的狀況下,辨識物為語言表徵 Linguistic Features, Representation Features),而後將訓練好的模型運作找出符合音素的參數放入 Vocoder 中,使其根據資料生成所需波形。

例如語言表徵為 i ,則生成模型則會生成 x 參數讓 Vocoder 對應生成波形,最後透過數位類比轉換、喇叭播出。

補充概念 - 前述提及 Concatenative 所指的語言樣本資料庫,正式名稱為一個包含語言中所有 Phoneme 的合集,術語為 “文本總集 Corpus, 文集”

Gooogle 的語音發聲到 Apple 結合資料庫的生成式語音 Siri

在此階段所開發的知名模型中,尤以 Google 所發表的深度學習模型 Wave Net 生成模型最為知名,在 2015 年對外發表後,於 2016 年開始應用在 Google 翻譯、助理中。

當時最為人頌讚的功能是,說著不同語言的兩個人可以使用翻譯以及語音功能達到近乎即時且自然的對話,這是從前人們無法想像的。

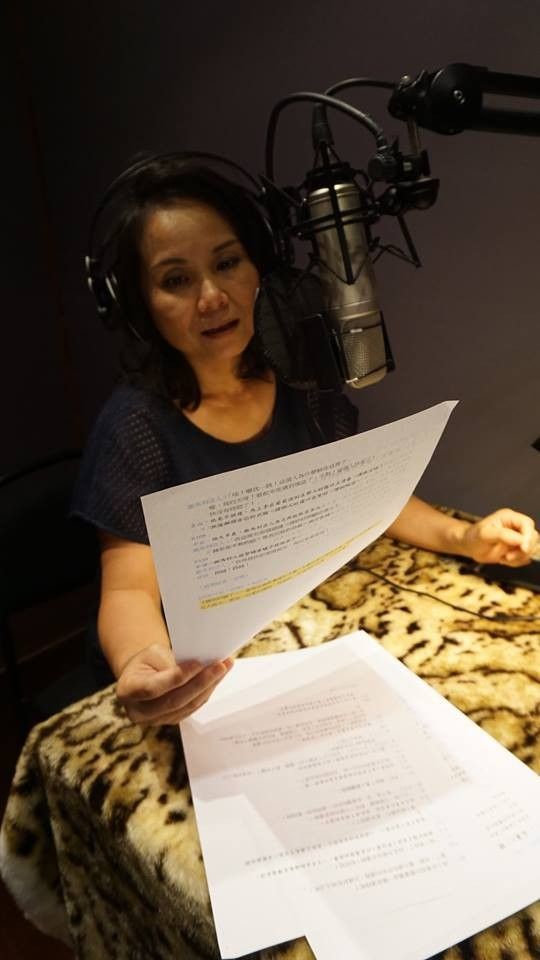

Apple 所推出的語音助理也結合了一個預訓練的資料庫,不過值得一提的是,蘋果在最初推出時,採用的是湊合式合成(Concatenative Sound Synthesis),也就是需要錄製語言 Phoneme Database 的方式,也意外造就了當時 Siri 的臺灣繁體配音員盧怡君小姐的爆紅,她曾在接受媒體訪問時透露當時被要求需要以一樣的語速在一個月內錄製數十萬字的文本, Siri 頻藉著結合 iOS 軟體生態系的優勢在當時被認為是人工智慧衍生服務的一大進展。

此方式的優勢為無須預先錄製,也無需龐大的資料庫儲存供提取的樣本資料庫(Samples Database),但相信歷經初代 Google 語音及當時其他類似產品的讀者都有同感,以此技術所合成的人聲較為平淡、沒有感情,在長語句時會產生不連貫、不自然的現象產生(同樣無法改變聲音的語氣、音調與情緒)。

簡介 VALL-E / AudioLM

就在語音合成技術快被其他更引人注目的 AI 專案淹沒之時,由微軟(Microsoft)所資助研究團隊給出了讓 TTSS 再度發光的新成果:

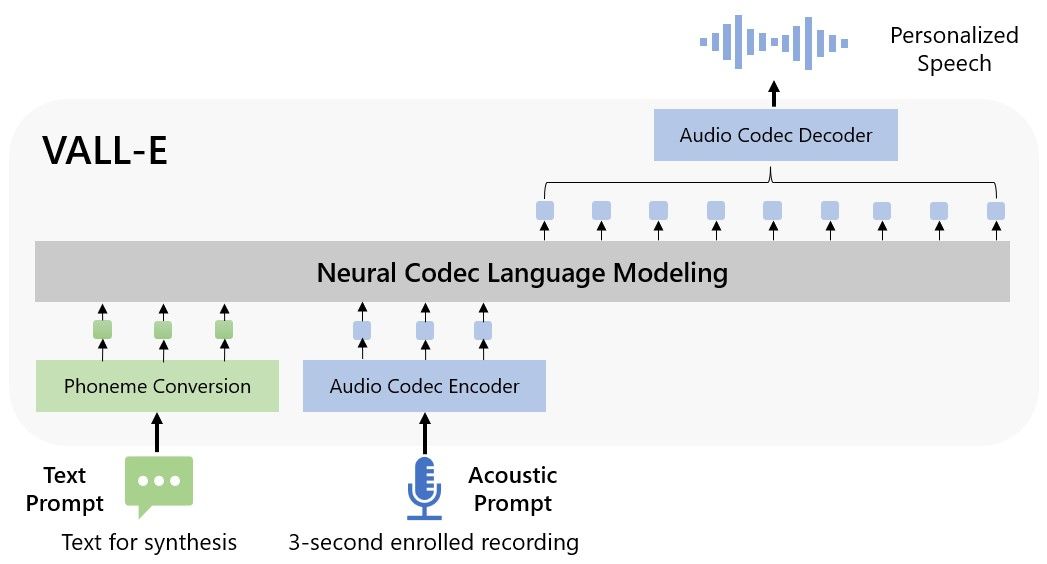

Variational Audio to Latent Language Encoder ,簡稱 VALL-E

VALL-E 為一個已經訓練好的生成模型,據團隊公開的論文指出,這個即將推出的程式能夠在沒有龐大聲音資料庫提示的情況下,模擬出那個人的聲音。

更誇張的是,團隊表示只要能夠聽到一個人 3 秒鐘的聲音,即可完全模擬、複製出一模一樣的成果,且可以改變語氣、以其聲音生成更多結果,也就是說,讓那個人以不同的情緒、語速說出他不曾說過的話。經過試驗者比對,是無從分辨真假的。

這對於原先效果並不怎麼好的零樣本 TTS 來說,可為踏實的一大突破。

不僅如此, VALL-E 還能夠模擬並還原出聲源當下的環境,是的,不僅是主要音源,連當下說話者的背景聲學空間都能夠還原。

ChatGPT 相輔相成?

ChatGPT 已經相當強大,若是能夠用人類的語氣自然地說話,那想必會挑戰恐怖谷的深淵了。

*指 Uncanny Valley *

VALL-E 團隊更近一步指出,未來將會串接開放的 ChatGPT 的 API ,讓 “它” 開口與人類順暢且生動的對話,這樣的情景似乎讓 Blade Runner 、 Love, Hate, Robot 等出眾的科幻作品所建構的世界真的不遠了呢。

不過在那之前,目前團隊已指出諸多可以實際應用之處,例如協助讓聾啞人士開口,或製作有聲讀物、 Podcast 節目等等。

音樂製作、創意產業的震撼彈 MusicLM

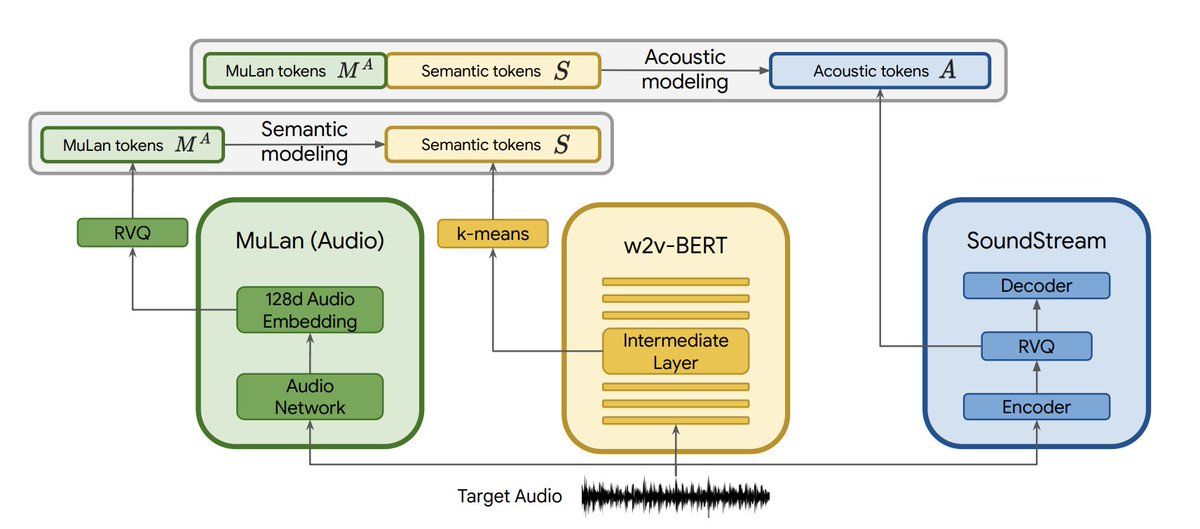

比 VALL-E 更早公開,由 Google 旗下團隊打造的 AudioLM 與 Vall-E 採用了類似的技術(技術部份會在下一節敘述),且有相似的目標及願景,而就在 AudioLM 持續開發修正之時,他們推出了另一個更為有趣且驚人的成果: MusicLM

想像一下,若這些研究的成果能夠產生人類的聲音,且讓聲音流暢且不間斷自然的延續,那麼,這是否可以應用在其他相符的概念上呢,例如說, “音樂” ?

沒錯, MusicLM 是一個可以根據文字描述自動產生音樂的工具, Google 於去年(2022)發表公開論文《MusicLM: Generating Music From Text》之時,大家一開始皆是不以為意的,這很正常,文字轉音樂早就有許多團隊正在開發,例如 OpenAI 的 JukeBox 專案,再加上當時大家還正被 Stable Diffusion 等文轉圖應用震撼當中, MusicLM 一開始並無造成太大的波瀾,但時隔幾日,大家似乎注意到 MusicLM 非同小可之處,進而開始造成轟動。

相較於之前的相關應用, MusicLM 能夠更加精準的描述你想製作的音樂,並根據文本精準且流暢地製作出一般歌曲時長的音樂作品,只要是稍微知曉計算運作的人們,就大概可以瞭解要產生這樣的成果是多麽困難的一件事,除了要理解文字描述、篩選並排除意義外,更要製作出通順的,不間斷的聲音。

1.輸入文字 2.理解並篩選文意 3.運作 4.生成音樂

例如輸入:有滂薄氣勢的美國西岸風街頭音樂, 160 BPM ,即可得到演算後生成的音樂

可以由此處連結進入 MusicLM 的學術論文,網頁下方有團隊的測試音檔可以供試聽

補充概念 - MusicLM 所使用的文本意義篩選法: 這邊先不提及聲音合成部分,我們來簡單看看他們如何篩選文本中的意義層。 根據資料, MusicLM 以 MULAN (Multi-Layered Network Model, 多層資料網絡模型) 結構來篩選需要生成的意義文字,這種模型能夠依照層級(Hierarchically)篩選、 Threshold 控管來幫助資料獲取方取得較為相近文本內涵的資料或資訊。

臺灣的科技圈約莫於 2023 初開始大量關注 MusicLM ,雖然現在因為不穩定, Google 並沒有開放使用,不過相信在不久的未來,網路上會開始滲入人工智慧所製作的音樂了,歌手們也可能會開始試著使用 AI 生成的 Beats / Background 來進行歌曲唱作,也有可能,連詞、曲甚至歌手的聲音都會是人工智慧加上 TTS 的也說不定。

簡介 TTSS 技術層面

類比訊號與數位訊號 - 人類與電腦、連續與離散(Continuous & Discrete)

在簡介 Vall-E 技術前,先簡單介紹一下自然界中的類比訊號與電腦中的數位訊號:

類比訊號是一個連續的、隨著時間推移持續維持或改變值的訊號,這個值可在範圍內任意變化,可以通過一條連續的曲線來表示,稱為波(形),經過特定方法調變(Modulate)後,可以用特殊載具來傳輸聲音、影像等等。

自然界中,被人類觀測到、定義後的線性值皆可稱為類比訊號,如溫度訊號變熱、音量大小訊號變弱等。

數位訊號則是一種能夠存儲於電腦中的訊號,是一種離散的訊號,只能存取一些特定的值,例如以二進位形式儲存則為 0 和 1。

通過將類比信號轉換(量化)成二進位,可以讓數據保存在電腦中,並進行各種處理。

簡單來說,人類以類比訊號溝通,我們的科技產物大多以數位為之。

新的語音產生方式...

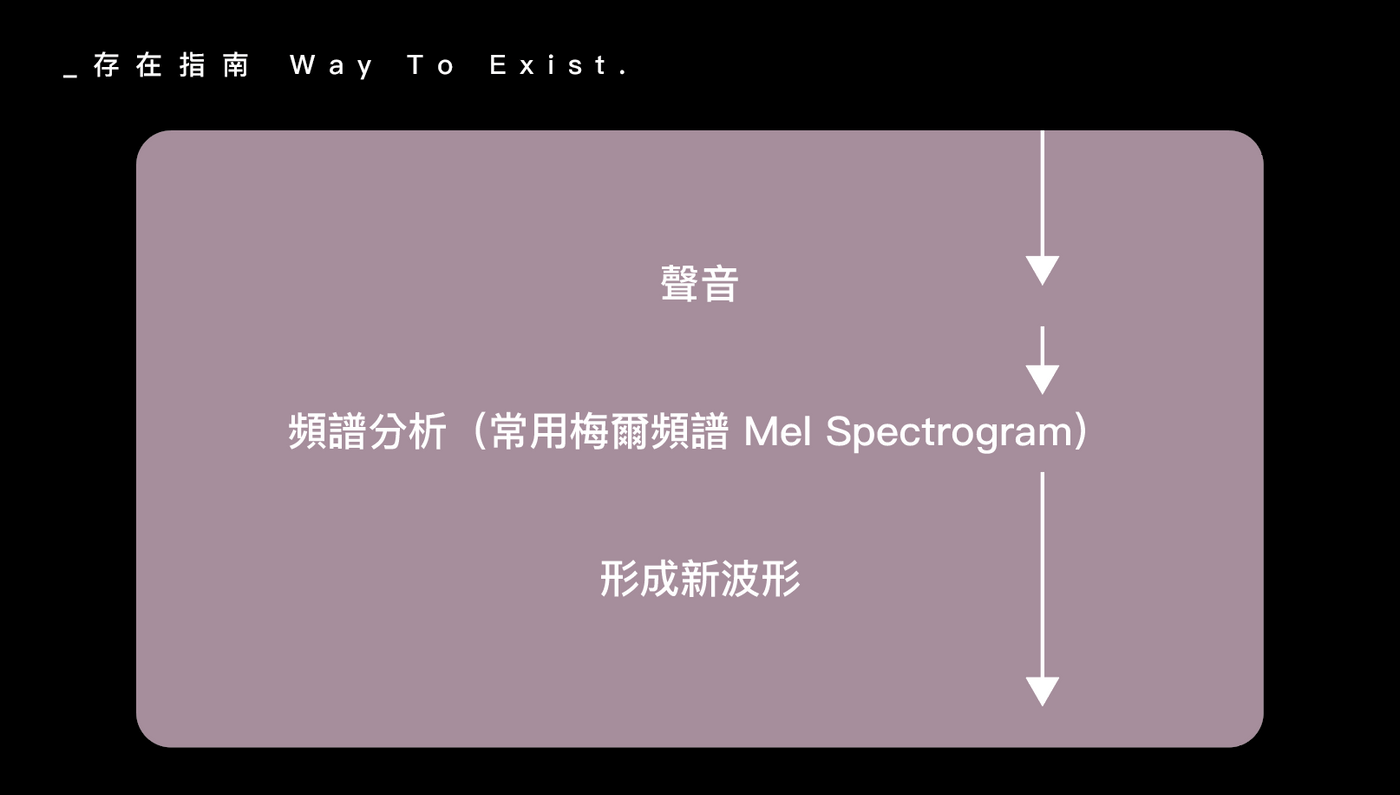

在舊有的語音合成模型上,大多由預先錄製到的音素(Phoneme)進行聲音頻譜解析,最常使用的聲音儀表頻譜為梅爾頻譜(Mel Spectrogram) ,形成頻譜後,在從上面提取聲音特徵並進而形成相關聲音的類比波形。

流程簡單來說是:1.聲音 2.頻譜分析 3.形成新波形

這樣的方式(零樣本生成)並不盡理想,聲音並不自然且不連貫、順暢。

數位化與 Token

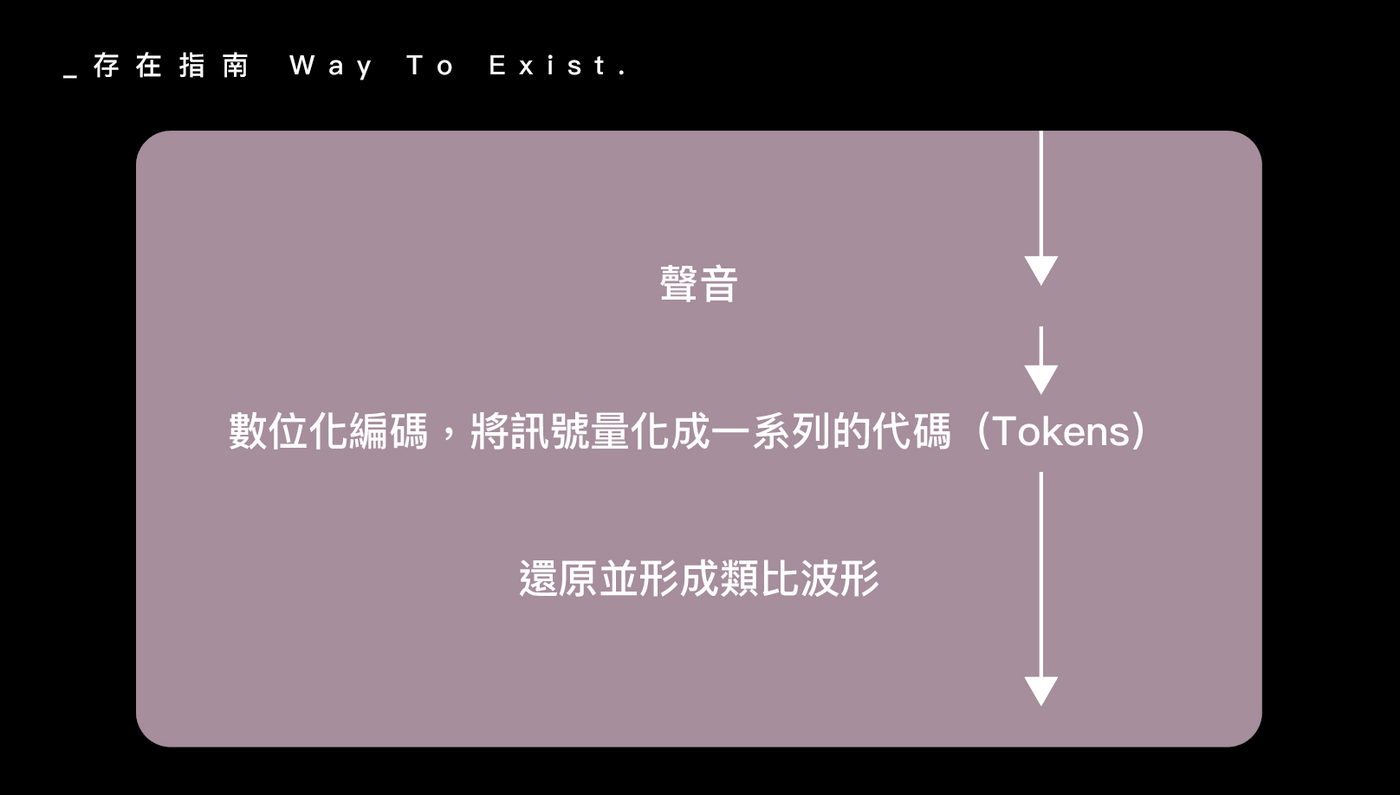

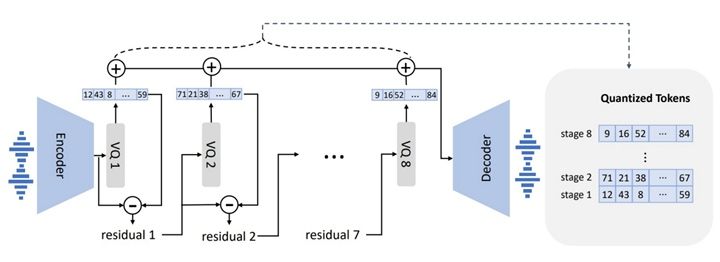

VALL-E 以及 AudioLM 的共通之處在於,兩者皆採用新的計算方式,將聲音的模擬當成一個必須存儲的 Task ,而為了達成這個 Task ,須將聲音數位化:

1.聲音 2.數位化編碼,將訊號量化成一系列的代碼(Tokens)3.還原並形成類比波形

在這個過程中,會有許多量化器,分別負責諸如捕捉聲音表徵、細膩化音訊等等。

補充 - 有人指出,此 Token 化的過程類似於很早之前問市的向量量化編碼模型 VQ-VAE(Vector Quantize Variational AutoEncoder)。

相較於 OpenAI 的 Whisper 專案

在訓練方面,通常資料集會相當龐大,但根據 VALL-E 文中所提及,他們只使用了 6 萬小時,的演講資料來初始化訓練 VALL-E 相較於其他模型例如 OpenAI 的 Whisper 用了數十萬小時的演講者聲音,實屬少了不少,且成果更為令人讚嘆。

在訓練方面,通常資料集會相當龐大,但根據 VALL-E 文中所提及,他們只使用了 6 萬小時,的演講資料來初始化訓練 VALL-E 相較於其他模型例如 OpenAI 的 Whisper 用了數十萬小時的演講者聲音,實屬少了不少,且成果更為令人讚嘆。

結語

這個不可能...

在近期,越來越多人工智慧生成模型的相關討論,其中,也聽到諸多認為現有的人工智慧仍無法正常協助我們創作、工作的論點,最常見的像是說 Stable Diffusion 不會畫人類的手指。

但仔細想想,在前些時間我們根本沒有見過這樣的技術,可以說是橫空出世即震懾世人,那麼可以見得的是,現在人工智慧領域的成長正以指數型攀升,也許這個禮拜畫不好手指,下週就能夠畫得比人工還好了,電腦不用休息、每秒鐘都可以被成長、進步。

語音合成的應用方面

VALL-E 的問世使得語音合成重新獲取不少關注,也衍生出相當多道德上的議論,例如模擬他人聲音冒用身份等,相信這些技術要如何被管制、使用是未來社會需要加以權衡的,但希望別再因類似問題而造成研發阻斷,就好比車廠打造了一台車子,駕駛蓄意在路上撞死了人,現代社會也不再會歸因給車廠,因為我們對汽車以習以為常了。我們不會再懼怕已經熟悉的科技。

Microsoft Copilot

在 2023 年 3 月(即此篇寫作時本月),微軟發佈了 “Copilot, 副駕駛” ,它能夠做些什麼?結合微軟生態系的 Office 各應用程式後,是否真的顛覆了我們這一代對於工作流程的定義呢?近期將會撰文介紹。

我們該開始認真地思索如何讓這些新技術成為我們的助手,與之合作,而不是屆時真的被取代了。

2023, 03 Taipei, Taiwan

盡情生活,

在浩瀚間留下存在的證明。|存在指南 Way To Exist