本地部署LLM并集成到Obsidian

ollama 是一个非常好用的本地部署 LLM 的工具,适合任何人使用,下载安装即可。

安装 LLM

我安装了两个大模型:8B 版本的 Llama 3 和 27B 版本的 Gemma 2。为此,分别运行:

ollama run llama3 和 ollama run gemma2:27b

之后,我们可以需要一个方便使用的交互界面。我选择了 Open WebUI,使用 docker 安装:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main如果想使用英伟达 GPU 来驱动 Open WebUI,可以:

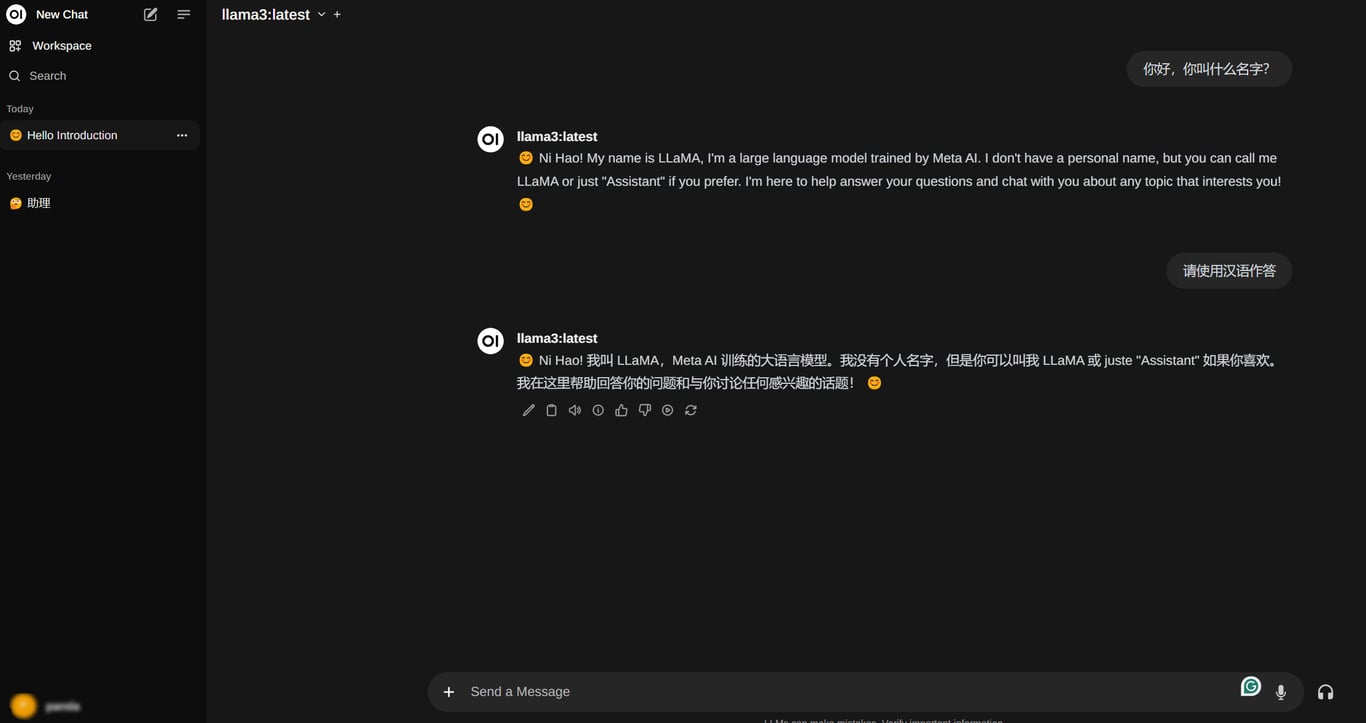

docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda之后只需在浏览器打开 http://localhost:3000/ 即可使用,界面与 ChatGPT 相当类似:

集成到 Obsidian

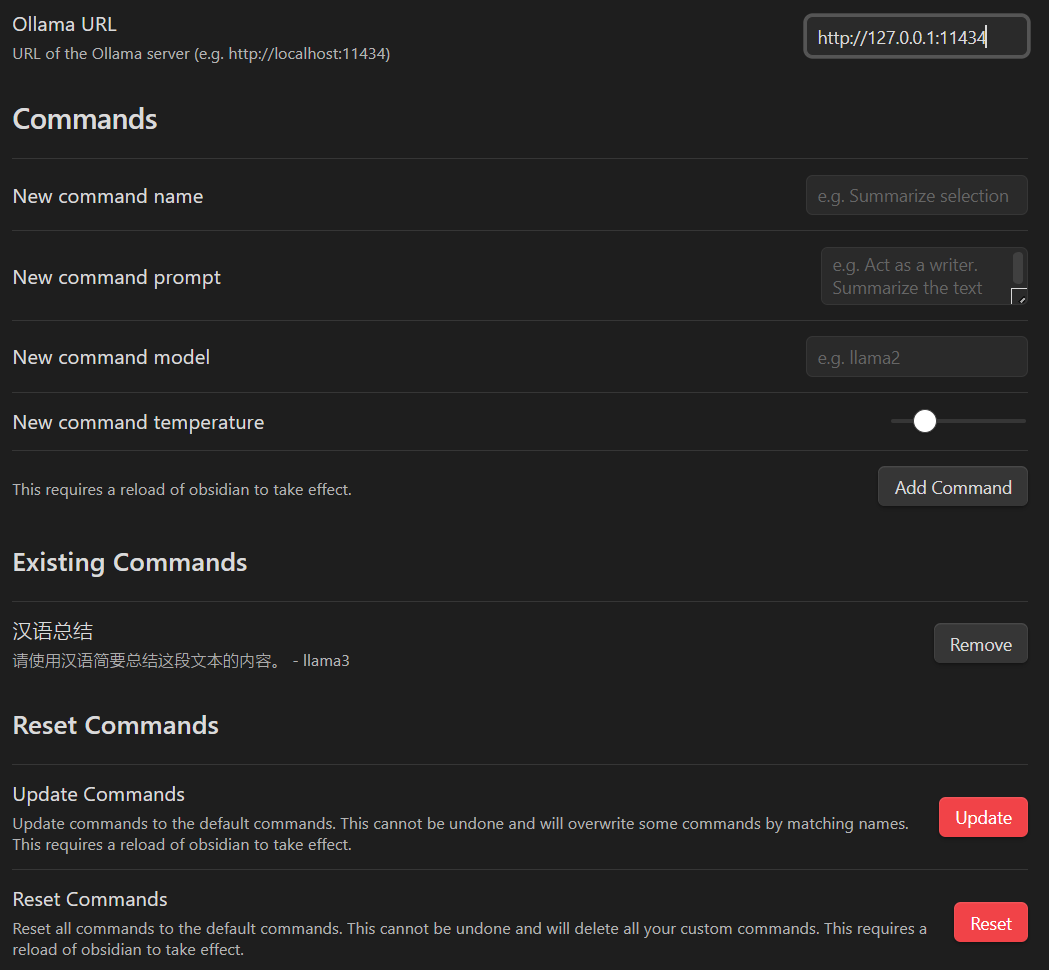

首先,在 Obsidian 的社区插件市场下载并启用 Ollama 插件,然后配置好你想使用的指令和模型。配置完成后记得重启一次 Obsidian,如此才能生效。

之后,在你需要使用 LLM 的文档中直接点击 Ctrl+P 或选中文本中 Ctrl+P 唤起命令工具,搜索你的命令名称,如上图中的「汉语总结」,调用即可。