链上数据分析到底有多麻烦| 善用Footprint Analytic 帮你省时间

前言

链上数据的分析不管是对于要了解一个项目或是你自己就是项目方都很有帮助。

试想你想要投资一个某个币,你可能会担心币的代币经济状况是否优良,这时候你就需要有链上分析的能力去看实际的现况,而不仅是在DC里面看着项目方跟支持者互相吹捧。

如果你是项目方的话,你可能发行了NFT,刚开始也卖得很好,但是过了几个月之后可能你就对于你的项目现况一片迷茫,透过分析链上数据,可以让你的项目不仅仅停留在发行成功,而是可以根据后续状况做出最适当的决策。

但是这件事是一件麻烦透顶的事情,本文会分享从零开始做数据分析需要经历的步骤与痛苦,以及如何可以善用工具快速达到你的目标避免这些无谓的麻烦。

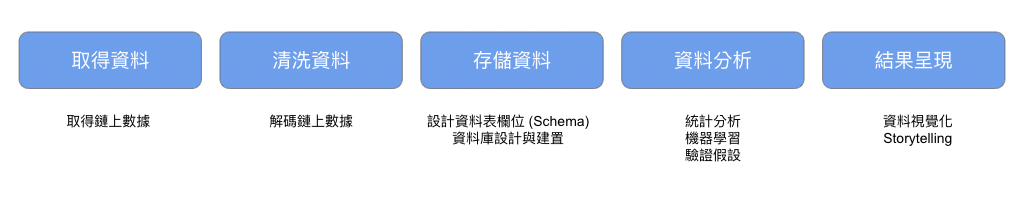

从零开始的链上数据分析

取得资料

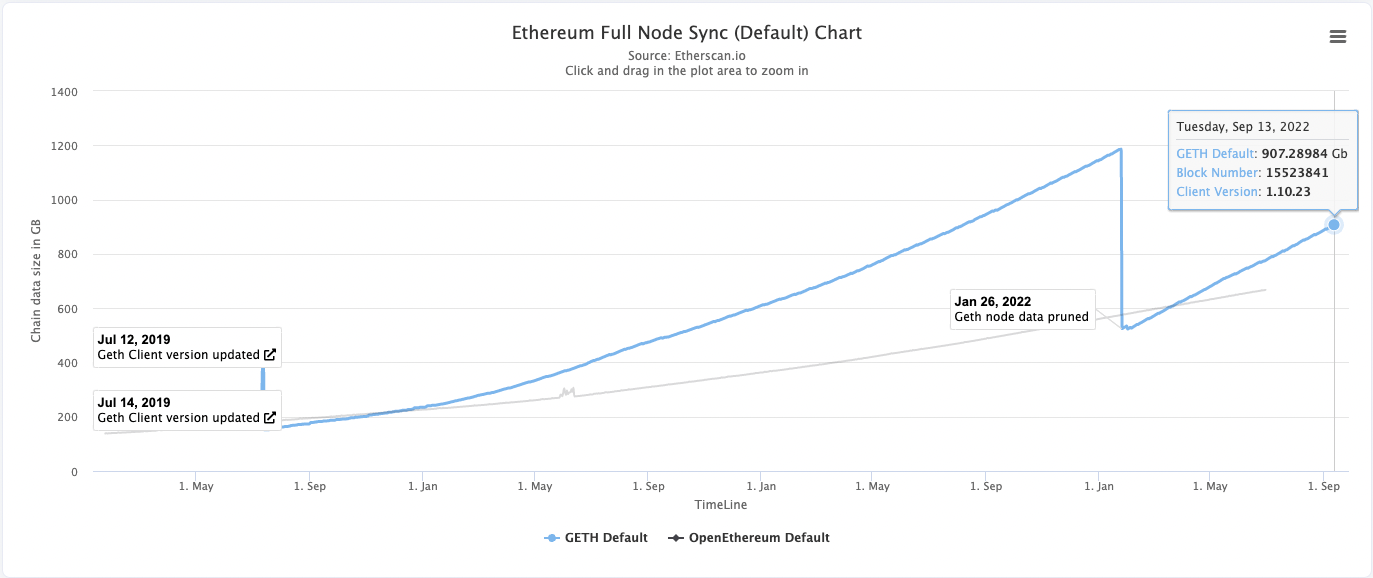

最麻烦的方法是自架一个节点,并且用这个节点同步区块链的历史资料,上图是目前以太坊历史资料的资料大小,因此最少需要准备1TB的SSD储存空间,同时还要准备其他的硬体设备(详细硬体需求可以参考),另外同步时间会根据硬体设备的速度有差异,根据经验需要花一周左右的时间可以同步到最新的区块。

由于自架节点太痛苦,因此有些服务供应商例如Alchemy , Moralis都有提供让你可以去从他的节点取得链上资料,但是这些节点都有取得资料的限制,大部分时间免费方案都够用,不过就需要花比较多时间等待。

解码资料

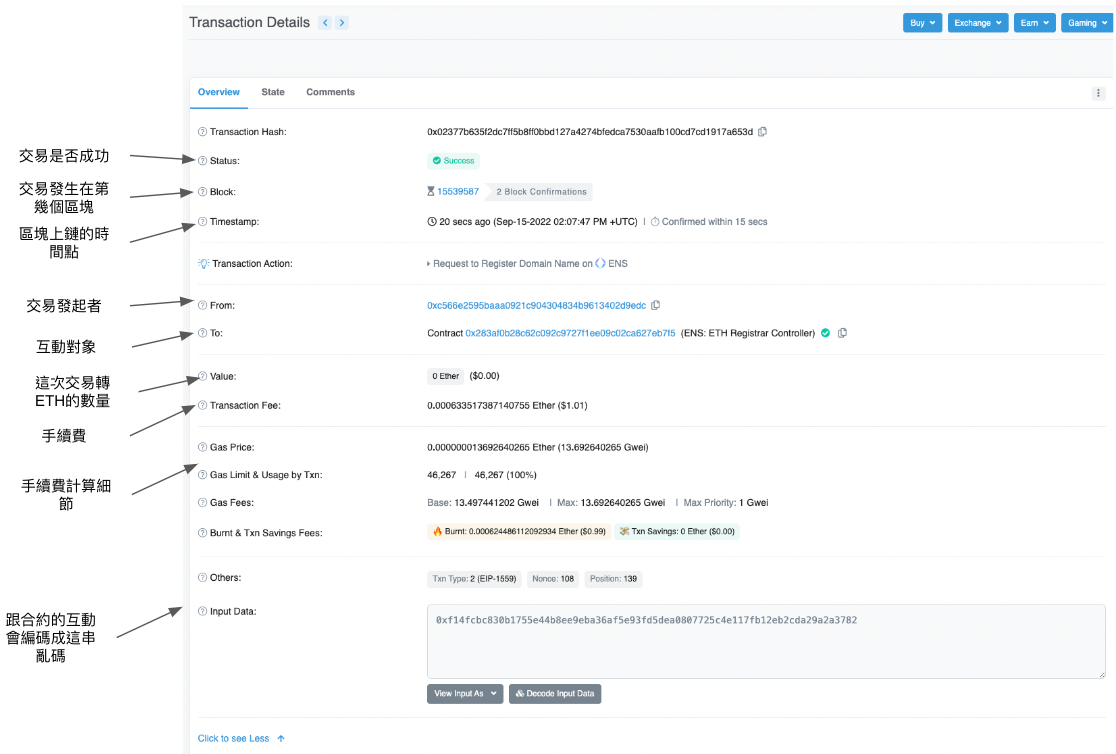

取得资料之后,就到了第二步-清洗资料。在这个时间点,你手边会有上千万笔Transcation 的资料。

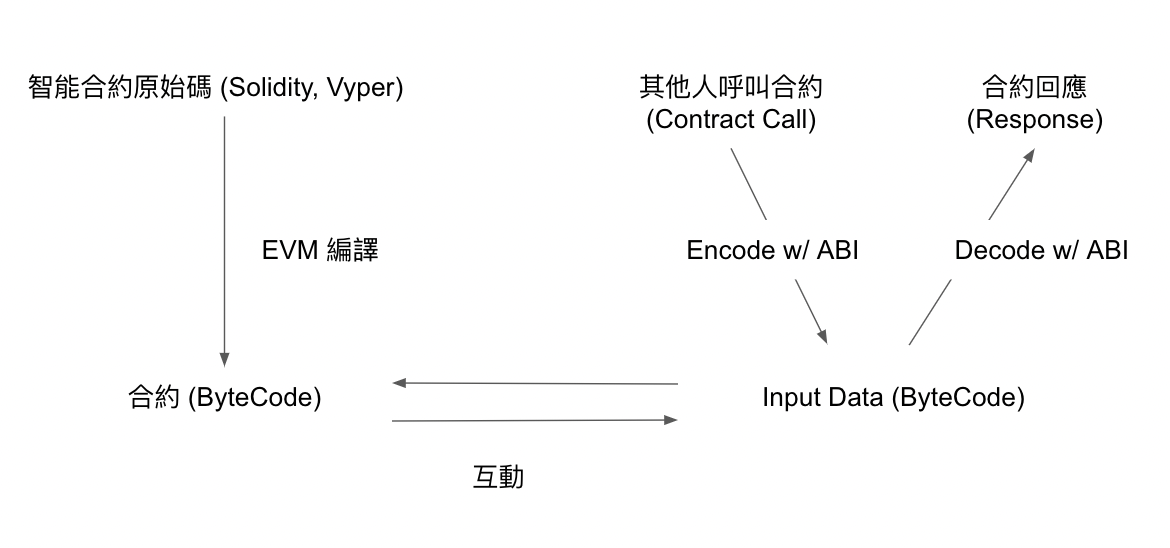

这时有着全世界的参与者跟链互动的资讯,下一步就是要能够将input Data解码(Decode)人能够看懂的样子。要做到这件事就需要有那些你想要解码项目的ABI 。

取得ABI需要靠项目方提供,另外如果项目方有上传Etherscan,也可以用Ethersan api去大量取得,解码不同的项目合约需要不同的ABI,因此如果你好奇的是世界百大NFT的资料,那就会需要搜集这一百种ABI。又是一段麻烦又辛苦的旅程,但是解码后就能够看到transcation究竟是发生了哪些互动,往分析数据快乐找洞见又往前了一大步。

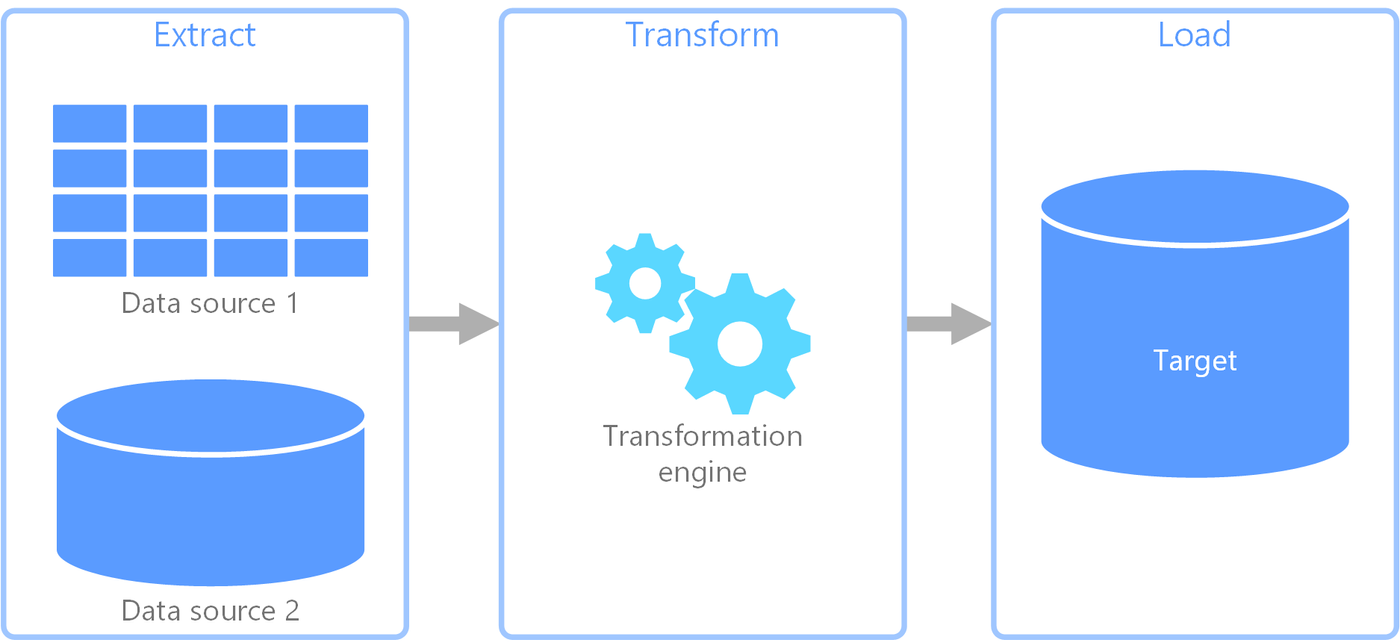

整理资料

资料解码完成后,还需要进一步的整理成容易使用的表格或是资料库。

由于在取得资料的时候手上的是世界上所有交易数据的资料,因此在这一步要将这些资料按照需求整理成好取用的格式,并存进资料库中方便接下来进一步的分析。

这一步可以参考Ethereum-ETL工具来根据你的需求设计Schema 整理资料成表格资料(csv) 或是关联式资料库。到这一步,资料终于变成可以用的形式啦!

资料分析<br class="smart">到了这一步,各位资料科学家应该迫不及待了,可以用各种统计甚至机器学习工具来从整理好的资料中提取洞见,解开心中的疑惑,验证自己的假设。

呈现结果<br class="smart">分析完成后,可能会想要将你的发现发到twitter或是个人blog上,这时候不可或缺的就是一张精美的,配合你的故事的图表。常用的工具像是Matplotlib, plotly 都可以帮助你。

以上就是一个从零开始分析链上数据的过程,但是整段过程充斥着太多麻烦与痛苦,整段过程需要3~4周的时间,最后的结果可能就是发一则tweet,或是你问的问题已经失去时效性了,接下来会分享善用工具的舒爽体验。

善用工具的链上数据分析-- Footprint Analytics

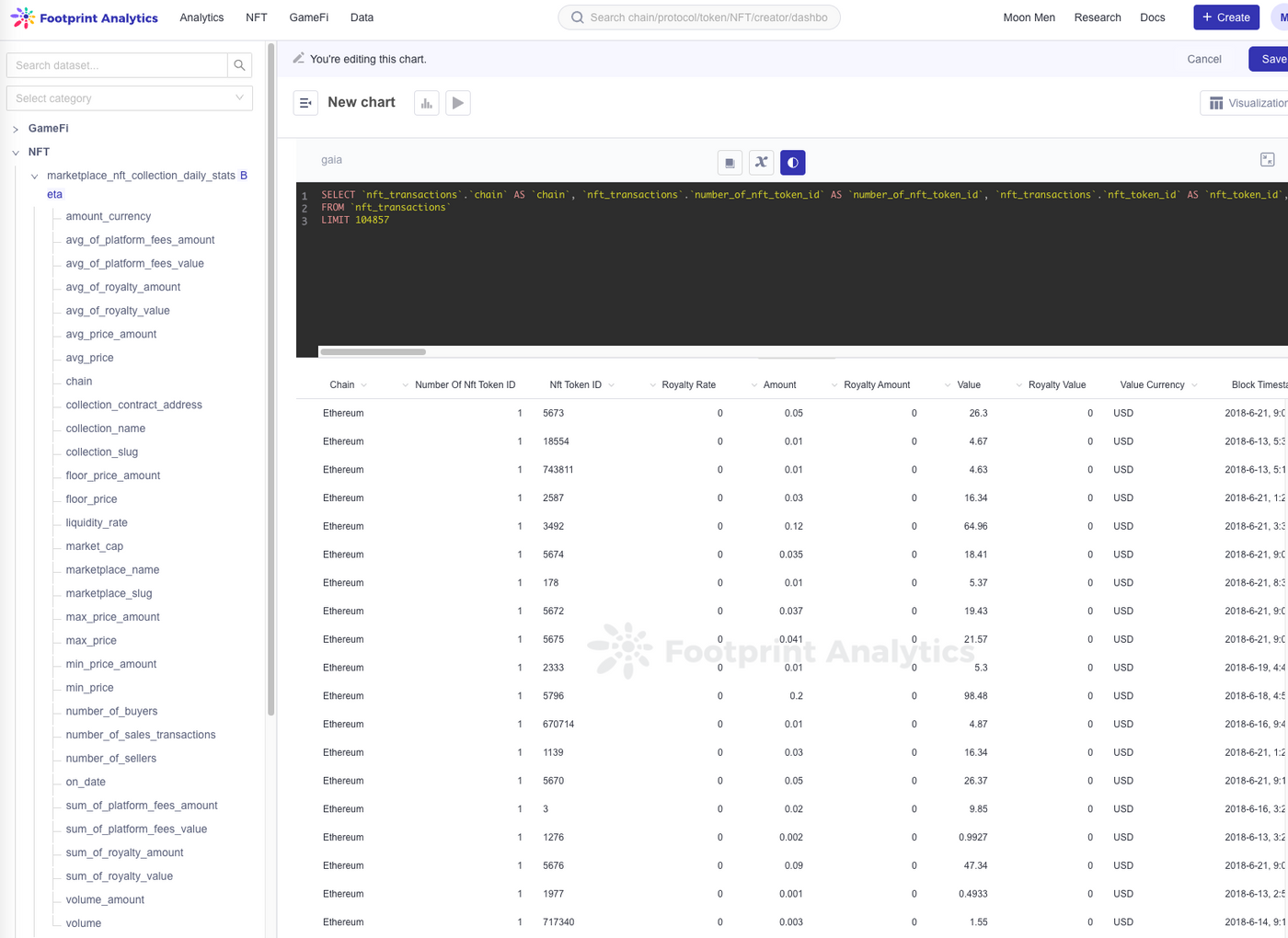

取得资料& 解码资料& 整理资料

通通不用自己来,Footprint Analytics 已经整理好了。

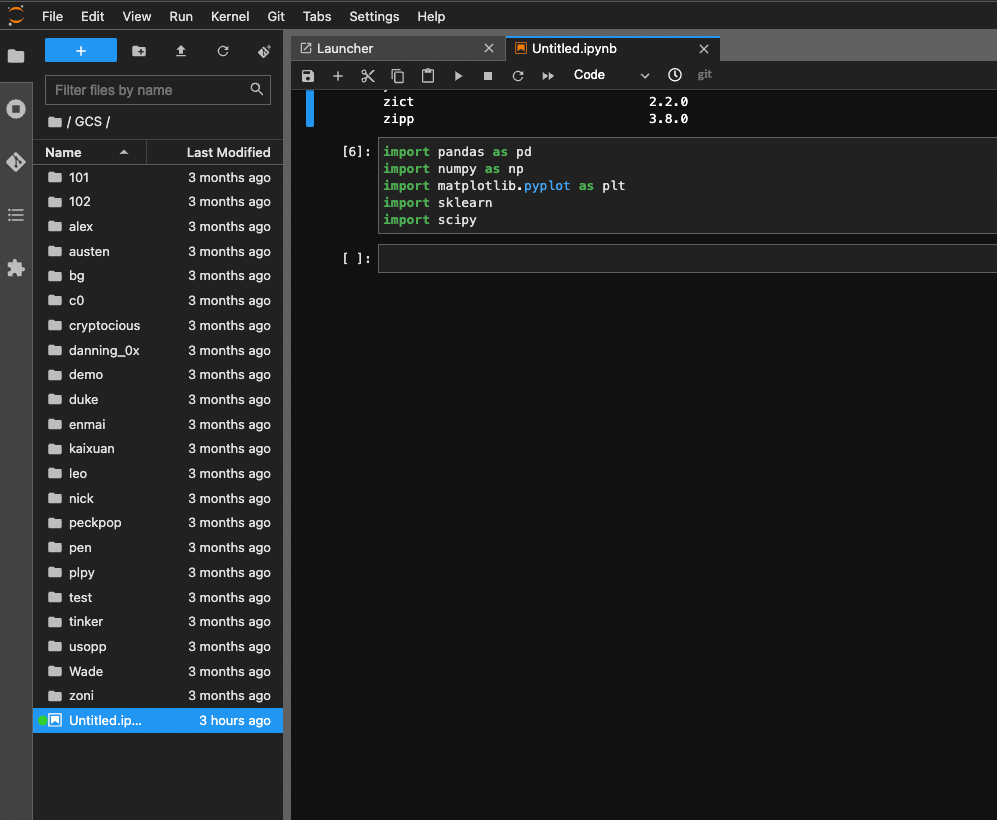

资料分析

资料分析除了使用SQL的指令计算一些统计值以外,也支援透过Playground 开一个jupyterlab 来做资料分析,这样就可以尽情用Python 强大的套件了!目前这个功能还是beta,期待以后更好用的样子!

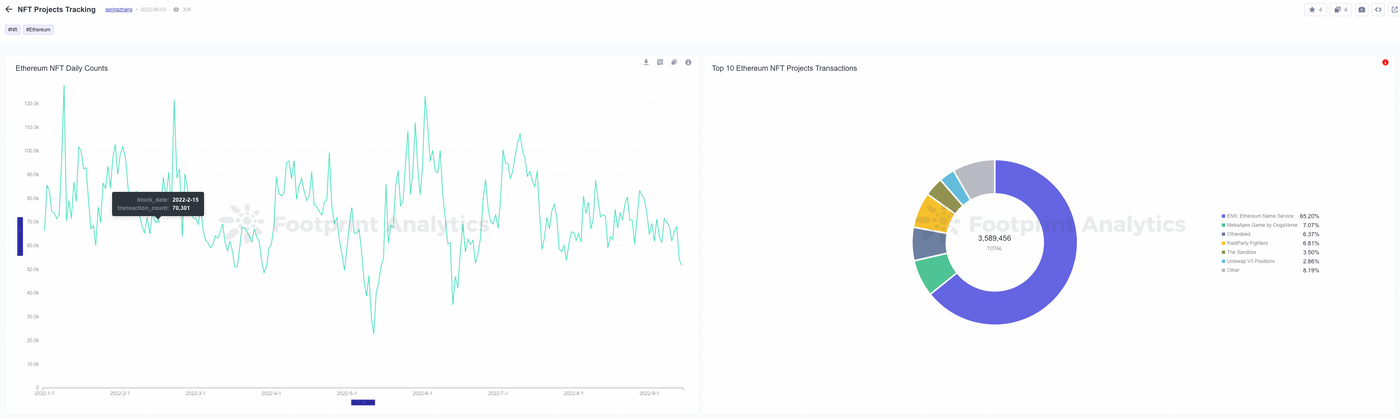

呈现结果<br class="smart">透过强大好用的内建功能,可以轻松建立可互动的仪表板。也可轻松将你的结果分享给其他人看,也可以看其他人对什么有兴趣,是如何着手分析的。

https://www.footprint.network/dashboards

结语

早期要做链上数据分析真的花了很多时间尝试,直到近年像是这样省时间好用的产品开始出现,真的可以省下大部分处理资料的时间,将时间专注在资料分析本身。

接下来我会持续分享分析链上数据的工具跟方法,喜欢的话请帮我赞赏或留言,谢谢看到这边。

https://www.footprint.network/@motif

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!