如何認識、理解和用好ChatGPT

對ChatGPT 的常見誤區是什麼?

首先,ChatGPT 是GPT 模型,全稱為"Generative Pre-trained Transformer”。目前是GPT3.5 代。 GPT 模型是一種LLM,本質還是語言模型,而不是不了解AI 發展的朋友們通常提到AI 所想到的AGI。

LLM VS AGI 區別是什麼

LLM的全稱是"Large Language Model",它是指以自然語言為基礎,利用深度學習技術構建的大型語言模型。 LLM 通過大量的訓練數據和算法,可以學習自然語言的規則和特徵,從而實現自然語言生成、理解、問答等任務。目前,最著名的LLM 是OpenAI 的GPT系列模型,包括GPT-3、GPT-2 等。

AGI的全稱是"Artificial General Intelligence",它是指一種能夠像人類一樣執行多種智能任務的人工智能係統。 AGI 是指能夠像人類一樣進行推理、學習、自我修復、自我意識等多種智能行為的智能係統。與LLM 不同的是,AGI 具有更廣泛的應用領域和更強的智能能力。

總的來說,LLM 和AGI 在技術層面和應用領域上存在著巨大的差異。 LLM 側重於自然語言處理和智能問答等任務,而AGI 則更為廣泛,可以在多個領域進行多種任務的處理和應用。此外,AGI 的研究和實現需要更為複雜和高級的技術和算法支持,與LLM 相比,還處於更早的研究和發展階段。

- ChatGPT 是語言模型,不是通用人工智能。

- 不要拿紅色蠟筆,想畫藍色海洋。

介於很多朋友閱讀速度很快,這裡狠狠重複一下……如果只有一個take away,那就是這兩句。

如何理解ChatGPT

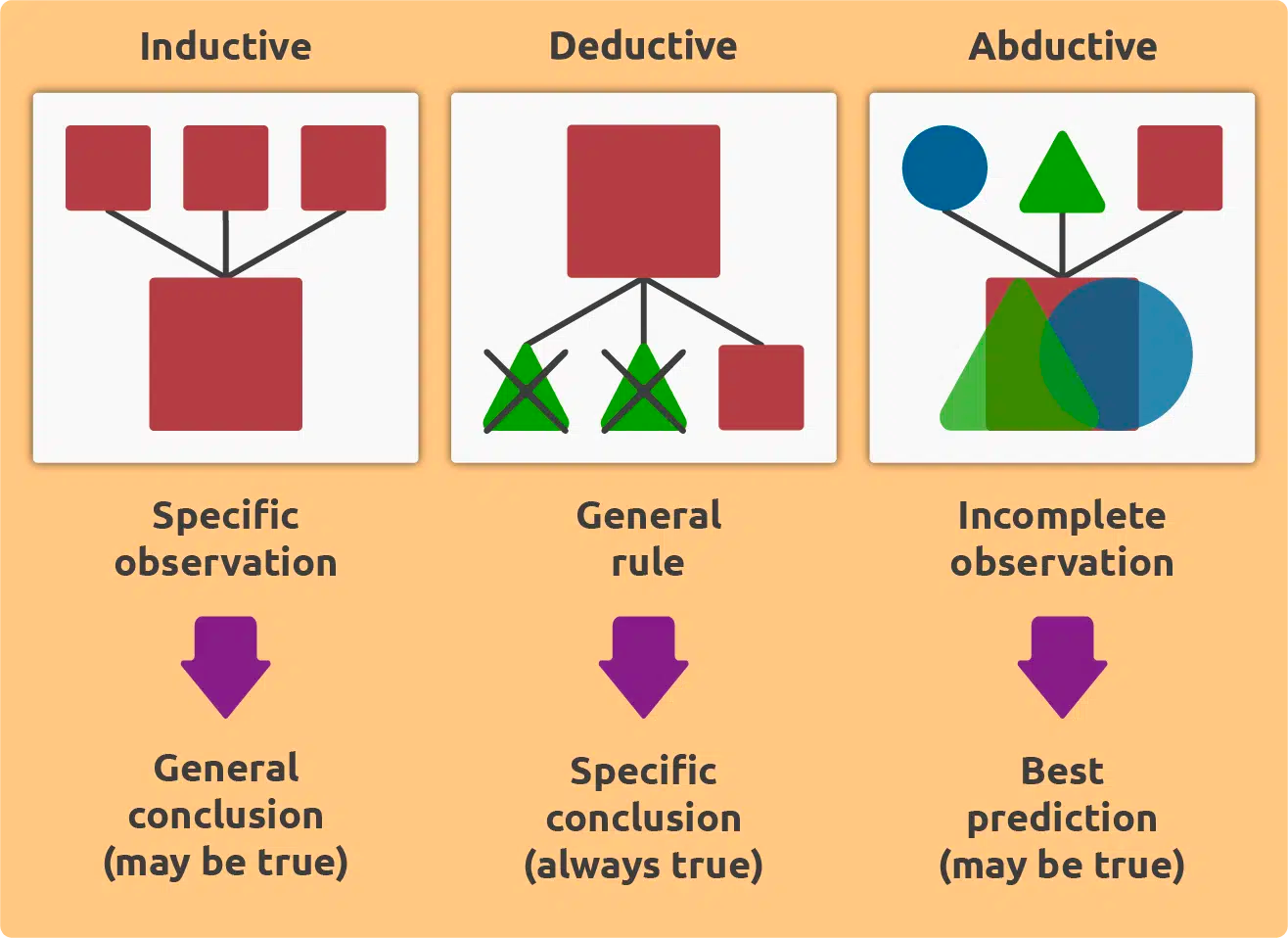

想要理解ChatGPT,首先要理解這三種邏輯推理方法。

- 歸納邏輯Inductive Logic(什麼是ChatGPT 能做的)

- 演繹邏輯Deductive Logic(什麼是ChatGPT 暫時不能做的)

- 溯因邏輯Abductive Logic(什麼是人能做,但ChatGPT不能的)

假設有一個實驗,研究人員對某種新藥進行了臨床試驗,並對試驗結果進行了數據分析。現在我們來舉例說明這三種邏輯推理方法如何應用於這個實驗。

歸納邏輯

- 在歸納邏輯中,我們通常從特定的實例中歸納出一般的規律和定律。在這個例子中,我們可以根據試驗的結果,觀察這種新藥的療效,然後推斷出這種新藥在人類中的作用規律。例如,如果試驗表明該藥物可以有效地治療某種疾病,那麼我們可以推斷這種藥物對該疾病具有普遍的治療效果。在這個過程中,我們從特定的實例中歸納出了一般的規律,這是歸納邏輯的一個典型應用。

演繹邏輯

- 在演繹邏輯中,我們通常通過利用已知的普遍規律或定律來推導出特定的結論。在這個例子中,我們可以利用已知的醫學原理和已知的藥物成分等信息,來推導出該新藥物是否具有治療效果。例如,如果我們已經知道了該藥物的成分,以及這些成分對人類身體的作用規律,那麼我們就可以通過演繹邏輯的推理方法,推導出該藥物對某種疾病是否具有治療效果。

溯因邏輯

- 在溯因邏輯中,我們通常通過選擇一個最有可能的解釋來解釋已知的事實或現象。在這個例子中,我們可以根據已知的實驗結果,以及已知的醫學原理和藥物成分等信息,選擇一個最有可能的解釋來解釋這些實驗結果。例如,如果我們發現這種新藥物具有治療某種疾病的作用,但我們尚不確定該藥物的作用機理是什麼,那麼我們可以通過選擇一個最有可能的解釋來解釋這種藥物的作用。這種解釋可能是該藥物作用於某種特定的細胞或分子,從而產生治療效果。在這個過程中,我們通過闡述邏輯來解釋了已知的實驗結果。

歸納邏輯Inductive Logic

- 什麼是ChatGPT 能做的?

- LLM 的本質是統計學,所以學習了大量語言數據的ChatGPT 有很強的語言組織能力,並不是因為它精通語義學,而是它知道一個詞後面大概率跟什麼詞,大概率組成什麼句子。 ChatGPT 行文組織的能力,是基於統計學而不是語義學,更不是專業領域的知識體系。

- 這幫助我們理解ChatGPT 擅長的任務是什麼、該如何和ChatGPT 溝通、如何高效利用好ChatGPT。

演繹邏輯Deductive Logic

- 什麼是ChatGPT 暫時不能做的?

- ChatGPT 之所以寫出漂亮的文章或措辭,不是因為它有很強的文學造詣,而是因為人類提供給它足夠優秀的訓練語料,讓它知道在漂亮的文章裡,一個詞後面大概率跟什麼詞,大概率組成什麼句子。換言之,ChatGPT 不具備任何從專業領域的知識體系中,推理分析內容的能力。即使在任何例子中,它看似完成了這一點,也是因為統計學而不是真正具備這樣的能力。因為通常這樣的結果是經不起推敲和辯駁的。

- 這幫助我們了解ChatGPT 的邊界是什麼。 ChatGPT 的輸出結果哪些是可信的、哪些是需要質疑的。哪些任務是目前不值得你向ChatGPT 提出的、ChatGPT 未來努力的方向是什麼,KG 研究未來有沒有結合的可能性。

溯因邏輯Abductive Logic

- 什麼是人能做,但ChatGPT 不能的?

- ChatGPT 目前被訓練得非常得體,遵守禮儀規矩,說不出錯的話。換言之,ChatGPT 不能說“胡話”。 (如果是專業知識的胡謅,屬於上一種類型)這跟ChatGPT 是Inductive Logic 的表達也有關。 ChatGPT 無法跳出學習資料以外回答你。也就是說,ChatGPT 還不具備對未知現象提出假設的能力。儘管大多數人未經訓練也不具備這個能力。

- 這幫助我們了解ChatGPT 做不到,但人有可能做到的事情。人在未來的競爭力是什麼,而一旦ChatGPT 展露出具備這種能力時,又意味著什麼。

如何用好ChatGPT

網絡上關於ChatGPT 的Prompt 一搜一大把,這裡簡單推薦幾個網站。

https://platform.openai.com/examples

https://github.com/f/awesome-chatgpt-prompts

簡單說下ChatGPT 擅長的任務:

一、回答具體的知識問題

不管是coding、哲學觀點研究還是紫微斗數。

ChatGPT 是非常好的老師,它可以條理清晰、有針對性地回答你的問題,而且你可以不斷地追問細節。這意味著學習資源空前平等,只要你有心想學。但記住永遠保持質疑精神。

通常全網知識越常見的內容,回答越好,反之越差。比如中醫藥、八卦五行的問答裡,就會存在胡說八道的情況。但是偏門知識也有引導的tricks,比如在新建對話中,先從ChatGPT 可能更容易聊對的內容/概念聊起,再去問你想知道的問題。這是因為同一會話的歷史語料會作為prompt 影響到ChatGPT 的下一次輸出。越多的context 給到ChatGPT,它就能對特定語境下的特殊詞彙和問題,有更好的表現。

二、解決語言問題

練習英語表達、給代碼debug 、擴寫縮寫複述等等,只要是語言。

訓練了全網做多語言數據的模型,能力有多強不用我多說。在很多問題上,它甚至比你學校的老師,回答更出色。但仍然也有ChatGPT 解答不了的語言問題,不妨換個問法試試,或者先做些context 的輸入和引導。記住,我們用ChatGPT 是為了自己的進步成長,得到自己想要的知識,而不是為了刁難它,說出一句它果然不行。同樣的,永遠保持質疑精神。

三、高級廢話文學

週報、PPT、公文、申請、總結、運營文案、商務交流等等。

沒有比看過全網廢話文學的LLM 更能說高級廢話了。如果ChatGPT 寫不出來,只能說你prompt 水平不行。思路還是一樣的,只要你知道ChatGPT 是基於統計學的,把prompt 往你想要的內容上引就可以了。盡可能在會話中提供更多的細節、要求、上下文,一次問不出來,可以把問題拆成好幾個問,循序漸進得到結果。

四、輸出機器懂的語言

其他模型的prompt,其他框架/服務的指令、接口等等

嘗試把ChatGPT 想像成機器大腦,正在說language in the brian。你永遠想不到ChatGPT 可以給你多驚豔的輸出。

ChatGPT 有可能會帶來哪些影響

首先,我們聊過ChatGPT 是語言模型。那麼我們就要看語言意味著什麼?

- 語言是人類的交流工具,最主要的交互形式之一。

- 語言是網絡數據最大的載體,哪怕音頻、視頻都可以轉換成文本數據。

- 語言除了natural language,還有coding language,和language in the brain。

- 語言的邊界就是思想的邊界。

語言交互,文字或語音

- ChatGPT 已經改變了搜索引擎。可想而知未來會改變更多的交互形式。所有的檢索才能得到信息的場景,都可以嘗試加上對話入口。也就是說,更多的垂直領域,產品的使用指南、服務支持,都會從原來的文檔或笨拙的智能客服,全面轉向GPT 模型+ 弱人工的處理形式。未來將會有很多對話語料設計與分析的場景。

- 所有工具類、效率類、任務導向的APP/交互/功能都將面臨智能化的轉型。數字化轉型曾經歷的事情,都有可能在智能化轉型中經歷一遍。包括探索的過程和流程化、工程化、自動化。工具和效率類APP 首當其衝的原因是,LLM 是擅長coding language 的,自然從natural language 到coding language 也不在話下。對應到現在的研究領域就是NL2SQL,和所有NL2codes、2function、2commands 的擴展場景,都值得期待。

- 由於信息獲取方式的轉變,流量的入口也會一部分從瀑布信息流變成會話聚焦型。這種情況下,平台方無法像傳統的搜廣推rankings 給到內容創作者推薦和流量。那首先雙方的利益關係會被重建,以及如何再達到一種平穩的狀態。我們都需要思考新的商業關係、交互呈現形式以及技術手段,如何能滿足雙方的訴求。

語言的多媒體載體,文本、音頻、視頻

- 語言模型不僅賦能文本生成,也將極大降低分析和生成和語言息息相關的音頻和視頻內容。文本的模型處理能力,能將整個互聯網信息數據整合起來。再加上多模態模型的發展,圖片、聲音等都會加入整個語義網絡semantic web。語義網絡的未來近在咫尺。

- LLM 不僅會成為language 任務的copilot,比如GitHub 出的copilot 和notion 出的notionAI,還將成為大多數的生產工具的copilot,而且盡在咫尺,相信在2023 的下半年,就會爆發普及很多的x-copilot 的產品、工具和服務。

natural language,coding language 和language in the brain 讓ChatGPT 成為機器意識

- ChatGPT 在coding language 上的表現不輸natural language,是因為編程語言是有規則、有序的。 ChatGPT 在兩種語言上融會貫通的優越表現,已經表明ChatGPT 具備轉譯能力,傳統學術研究上是NL2SQL 賽道,但ChatGPT 能做的已經遠遠超過SQL。目前來看,沒有比ChatGPT 更適合成為機器的language in the brain。

- "Language in the brain" 是意識的一個重要組成部分,因為語言是人類意識的重要載體和表達方式。全局工作空間理論認為,意識是由全局工作空間中的信息所構成的,而全局工作空間是大腦中多個模塊之間共享的一個信息處理系統。語言作為一種信息的表達方式,在全局工作空間中扮演了重要的角色。全局工作空間理論(Global Workspace Theory)是由美國心理學家Bernard Baars 在1988年提出的一種心理學理論,它用於解釋人類意識的本質和機制。

- 為什麼ChatGPT 有潛力成為機器意識?

- ChatGPT 已經連接起自然語言和機器語言

- ChatGPT 已經具備交流溝通的能力

- ChatGPT 已經具備理解context 的能力

- ChatGPT 已經具備推理的能力

- ChatGPT 在context awareness 問題上表現出來的泛化能力和潛力已經超過絕大多數算法模型

- ChatGPT 目前還沒有成為機器意識,但我們可以通過finetuning 和prompt engineering 訓練它,讓它逐步模擬GWT

- 垂類高集成、高自動化、高智能的AI 指日可待

語言的邊界就是思想的邊界

- 美國語言學家和哲學家Benjamin Lee Whorf強調了語言和思想之間的互動性,並提出了"語言的邊界就是思想的邊界"的觀點。他認為,不同的語言系統對現實世界的理解和表達方式是不同的,因此人們的思想和理解也會受到語言的限制。

- 維特根斯坦認為,語言的邊界塑造思想的邊界,這意味著語言和思想之間存在著密切的關係。他認為,語言不僅僅是一種表達思想的工具,更是塑造思想的方式。因為語言決定了我們所能想到的東西,甚至塑造了我們的觀念和信仰。

- 過往我們接觸知識的來源五花八門,課堂、書籍、演講、討論……而現在ChatGPT 可以給我們不一定是最好的,但一定是最快的知識回答。網上看到一個比喻,說ChatGPT 是將幾十年互聯網的文本信息壓縮成低清縮略圖,使得用戶很快可以窺探全貌、看個大概。同時也因為高度壓縮,丟掉了很多細節。長此以往,隨著ChatGPT 的能力越來越強, 我們除了接受一手的ChatGPT 信息,還可能到處看到二手的ChatGPT 的半加工文章、播客和視頻。大量的ChatGPT 產出的信息將我們淹沒,下一代的小朋友會如何成長起來?他們會變成像ChatGPT 一樣思考、一樣講話嗎?

小結

只希望ChatGPT 能夠成為一個好工具,但不要成為人們放棄探索好奇心和思想邊界的藉口。

附

最近,和學中醫的朋友也聊到ChatGPT。友人深深表示部分傳統中醫脈絡可能因為沒有數字信息沉澱,而在這次智能化轉型中從網絡世界銷聲匿跡。

如有任何這類擔憂的朋友,都可以我號留言,探討可行的合作和幫助。

喜歡我的作品嗎?別忘了給予支持與讚賞,讓我知道在創作的路上有你陪伴,一起延續這份熱忱!